로컬 AI 이미지 생성 환경 구축: 무제한 이미지 생성을 위한 설치 가이드

클라우드 기반 AI 이미지 생성 서비스를 사용하다 보면 크레딧 제한, 월 구독료, 생성 속도 제한 등 다양한 제약에 부딪히게 됩니다. Midjourney나 DALL-E 같은 서비스는 편리하지만, 본격적으로 AI 이미지를 활용하려면 비용이 빠르게 늘어납니다. 로컬 환경에 AI 이미지 모델을 직접 설치하면 이런 제약에서 완전히 벗어날 수 있습니다.

로컬 AI 이미지 생성 환경을 구축하면 무제한으로 이미지를 생성할 수 있고, 인터넷 연결 없이도 작업이 가능하며, 다양한 커스텀 모델과 LoRA를 자유롭게 적용할 수 있습니다. 최근에는 Z-Image Turbo처럼 16GB VRAM만으로도 1초 이내에 고품질 이미지를 생성하는 효율적인 모델도 등장했습니다. 이 문서에서는 하드웨어 선택부터 소프트웨어 설치, 모델 다운로드, 커스텀 UI 개발까지 전체 과정을 상세히 다룹니다.

1. 로컬 AI 이미지 생성의 전체 흐름 이해

1) 로컬 AI 이미지 생성이란

로컬 AI 이미지 생성은 개인 컴퓨터에 Stable Diffusion이나 Z-Image 같은 이미지 생성 모델을 직접 설치하고 실행하는 방식입니다. 클라우드 서버가 아닌 본인의 GPU에서 모든 연산이 이루어지기 때문에 외부 서비스에 의존하지 않습니다. 한 번 환경을 구축하면 전기료 외에 추가 비용 없이 원하는 만큼 이미지를 생성할 수 있습니다.

- Stable Diffusion이 가장 널리 사용되는 오픈소스 이미지 생성 모델

- Z-Image Turbo는 적은 사양으로도 빠른 생성이 가능한 최신 효율 모델

- 텍스트 프롬프트를 입력하면 해당 내용의 이미지를 생성

- 다양한 커스텀 모델, LoRA, ControlNet 등으로 확장 가능

2) 전체 구축 과정 개요

로컬 AI 이미지 생성 환경 구축은 크게 네 단계로 나뉩니다. 먼저 적합한 하드웨어, 특히 GPU를 준비해야 합니다. 그 다음 Python 환경과 필요한 라이브러리를 설치합니다. 세 번째로 WebUI나 ComfyUI 같은 인터페이스를 설치하거나 직접 개발합니다. 마지막으로 원하는 모델 파일을 다운로드하여 적용합니다.

-

하드웨어 준비: GPU, RAM, 저장공간 확보

-

소프트웨어 환경 설정: Python, CUDA, 드라이버 설치

-

UI 설치 또는 개발: 기존 UI 사용 또는 Next.js/React로 커스텀 UI 구축

-

모델 및 확장 기능 설치: 체크포인트, LoRA, VAE 등 적용

-

Z-Image Turbo는 diffusers 라이브러리를 통해 설치하며, 기존 Stable Diffusion WebUI와 달리 Python 코드로 직접 실행합니다. 16GB VRAM 환경에서 1초 이내 이미지 생성이 가능하고, 저사양 환경에서는 CPU 오프로딩 옵션을 활성화하면 됩니다. 저사양 환경(812GB VRAM)에서는 코드에

pipe.enable_model_cpu_offload()한 줄을 추가하면 메모리 부족 없이 실행할 수 있습니다.

| 단계 | 작업 | 명령어 | 비고 |

|---|---|---|---|

| 1 | Python 설치 | 공식 사이트에서 다운로드 | 3.10.x 버전, PATH 추가 필수 |

| 2 | CUDA 설치 | NVIDIA 공식 사이트 | 11.8 또는 12.x 버전 |

| 3 | PyTorch 설치 | pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118 |

CUDA 버전에 맞게 선택 |

| 4 | diffusers 설치 | pip install git+https://github.com/huggingface/diffusers |

소스에서 최신 버전 설치 필수 |

| 5 | 의존성 설치 | pip install transformers accelerate sentencepiece |

필수 패키지 |

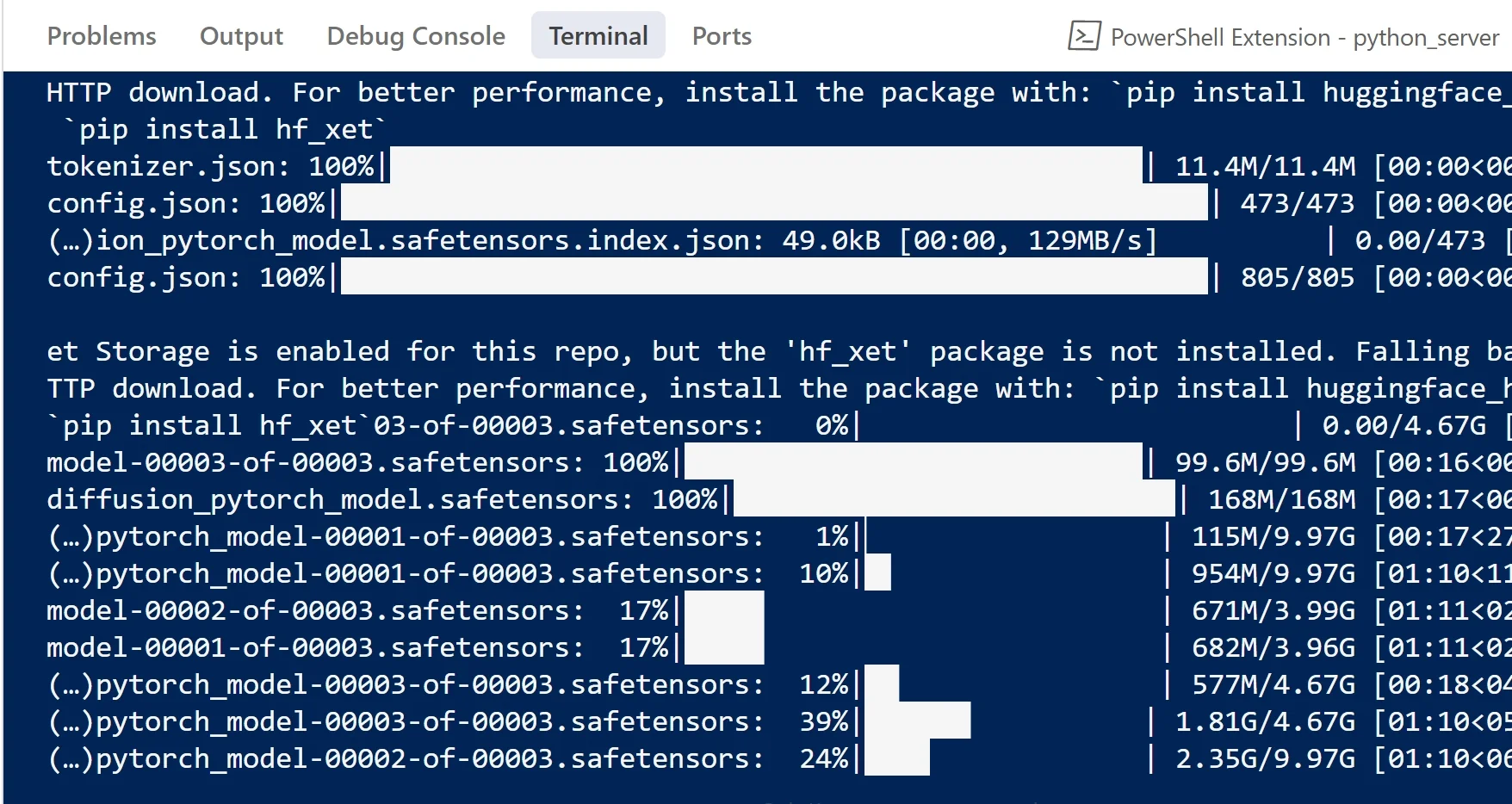

| 6 | 모델 다운로드 | pip install huggingface_hub 후 hf download Tongyi-MAI/Z-Image-Turbo |

약 12GB 용량 |

| 7 | 실행 | Python 스크립트 작성 후 실행 | num_inference_steps=9, guidance_scale=0.0 설정 |

3) 클라우드 vs 로컬 비교

클라우드 서비스는 초기 투자 없이 바로 시작할 수 있고 설정이 간편합니다. 하지만 월 구독료가 발생하고, 생성 횟수에 제한이 있으며, 커스터마이징에 한계가 있습니다. 로컬 환경은 초기 하드웨어 비용이 들지만, 이후에는 무제한 생성이 가능하고 완전한 자유도를 얻을 수 있습니다.

- 클라우드: 편리하지만 비용 누적, 제한된 커스터마이징

- 로컬: 초기 투자 필요하지만 장기적으로 경제적, 완전한 통제권

- 하이브리드 접근도 가능: 간단한 작업은 클라우드, 대량 생성은 로컬

2. 하드웨어 요구사항과 GPU 선택

1) GPU가 핵심인 이유

AI 이미지 생성에서 GPU는 가장 중요한 하드웨어입니다. Stable Diffusion 같은 모델은 수십억 개의 파라미터를 가지고 있고, 이미지 한 장을 생성하는 데 수백만 번의 연산이 필요합니다. CPU로도 이론적으로 실행 가능하지만, 한 장 생성에 수십 분이 걸려서 실용성이 없습니다. GPU는 병렬 연산에 특화되어 있어 같은 작업을 몇 초 만에 처리할 수 있습니다.

- VRAM(비디오 메모리)이 가장 중요한 사양

- 최소 8GB VRAM 권장, 12GB 이상이면 쾌적

- Z-Image Turbo는 16GB VRAM에서도 1초 이내 생성 가능

- VRAM이 부족하면 고해상도 이미지 생성이 제한됨

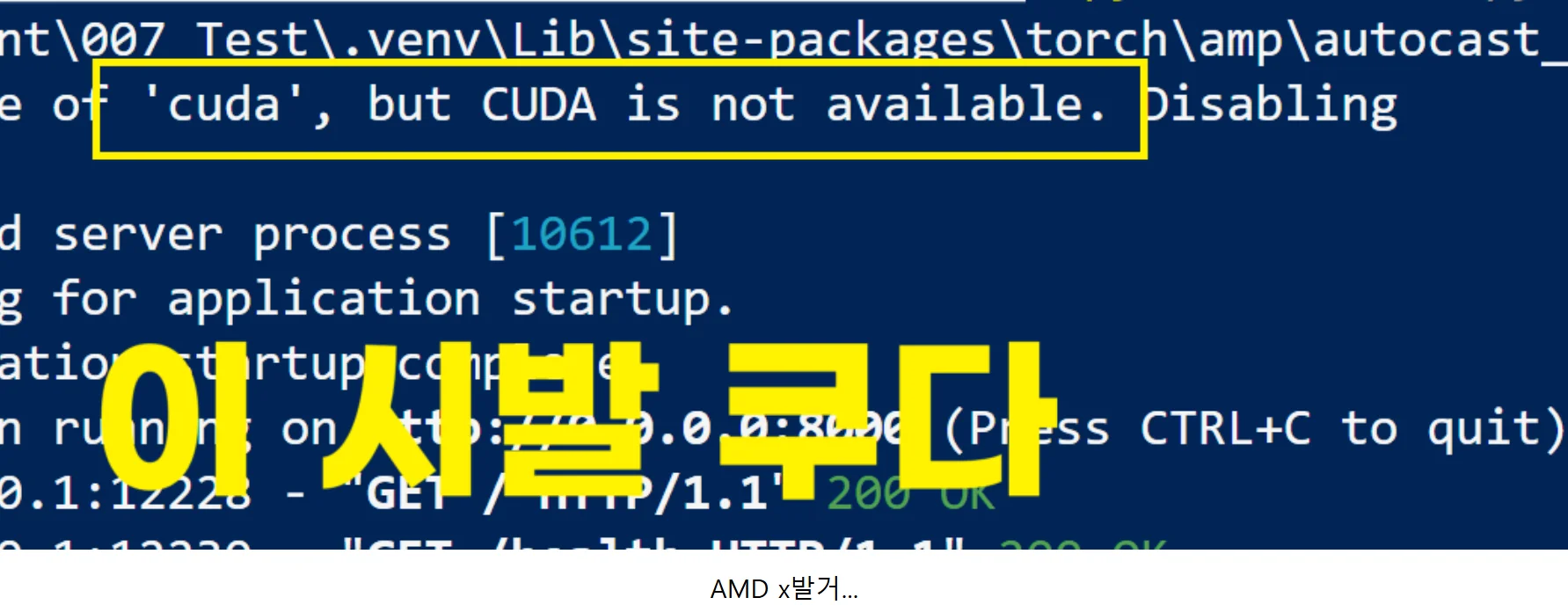

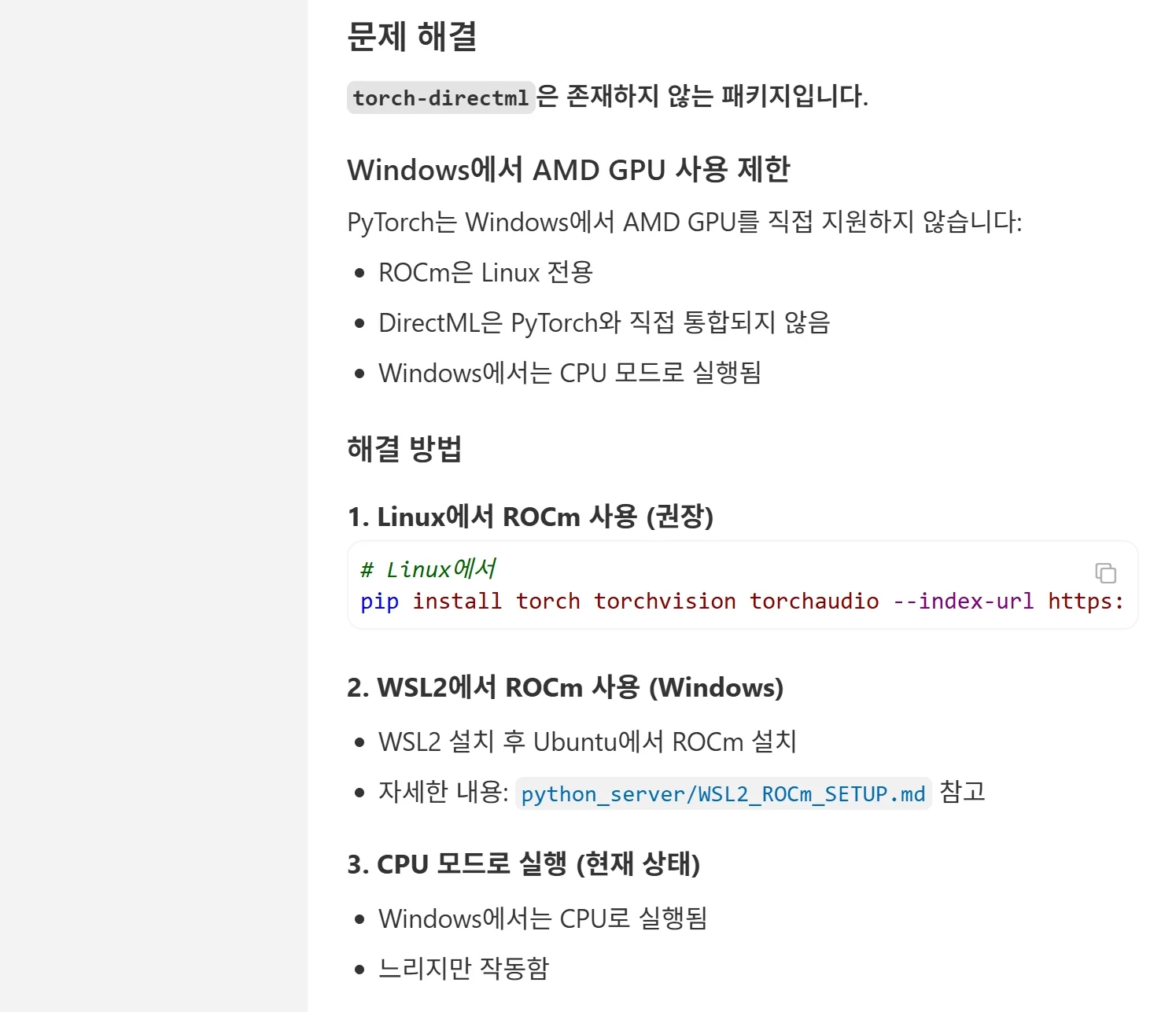

2) NVIDIA vs AMD: 왜 NVIDIA를 선택해야 하는가

현재 AI 이미지 생성 분야에서 NVIDIA GPU가 사실상 표준입니다. 이는 NVIDIA의 CUDA 플랫폼과 cuDNN 라이브러리가 대부분의 AI 프레임워크에서 기본으로 지원되기 때문입니다. AMD GPU도 ROCm을 통해 일부 지원되지만, 호환성 문제가 빈번하고 성능 최적화가 덜 되어 있습니다.

- NVIDIA 장점: CUDA 생태계 완벽 지원, 대부분의 튜토리얼과 가이드가 NVIDIA 기준, 안정적인 드라이버, 다양한 최적화 기법 사용 가능, Flash Attention 등 최신 가속 기술 지원

- NVIDIA 단점: 동급 AMD 대비 가격이 높음, 전력 소모가 큰 편

- AMD 장점: 가격 대비 성능이 좋음, 최근 ROCm 지원 개선 중

- AMD 단점: 호환성 이슈 빈번, 설치 과정 복잡, 일부 기능 미지원, 문제 발생 시 해결책 찾기 어려움, Z-Image 같은 최신 모델의 최적화 미지원

3) 권장 GPU 사양별 정리

예산과 용도에 따라 적합한 GPU가 다릅니다. 입문용으로는 RTX 3060 12GB가 가성비가 좋습니다. VRAM 12GB로 대부분의 모델을 무리 없이 돌릴 수 있습니다. 본격적인 작업용으로는 RTX 4070 Ti SUPER나 RTX 4080을 권장합니다. Z-Image Turbo처럼 효율적인 모델을 사용하면 16GB VRAM으로도 상당히 쾌적한 작업이 가능합니다.

- 입문/취미용: RTX 3060 12GB, RTX 4060 Ti 16GB

- 중급/준전문가: RTX 4070 Ti SUPER 16GB, RTX 4080 16GB

- 전문가/상업용: RTX 4090 24GB, RTX 5090 32GB

- 효율 모델 활용 시: 16GB VRAM으로도 Z-Image Turbo 쾌적 실행

4) GPU 외 하드웨어 요구사항

GPU 외에도 충분한 시스템 RAM과 빠른 저장장치가 필요합니다. 모델 파일 하나가 27GB 정도이고, 여러 모델을 사용하려면 수십 GB의 저장공간이 필요합니다. SSD는 모델 로딩 속도에 영향을 주므로 NVMe SSD를 권장합니다.

- RAM: 최소 16GB, 권장 32GB 이상

- 저장장치: 최소 100GB 여유 공간, NVMe SSD 권장

- CPU: 병목이 되지 않을 정도면 충분, 최신 4코어 이상

- 전원공급장치: GPU 전력 소모를 고려하여 650W 이상

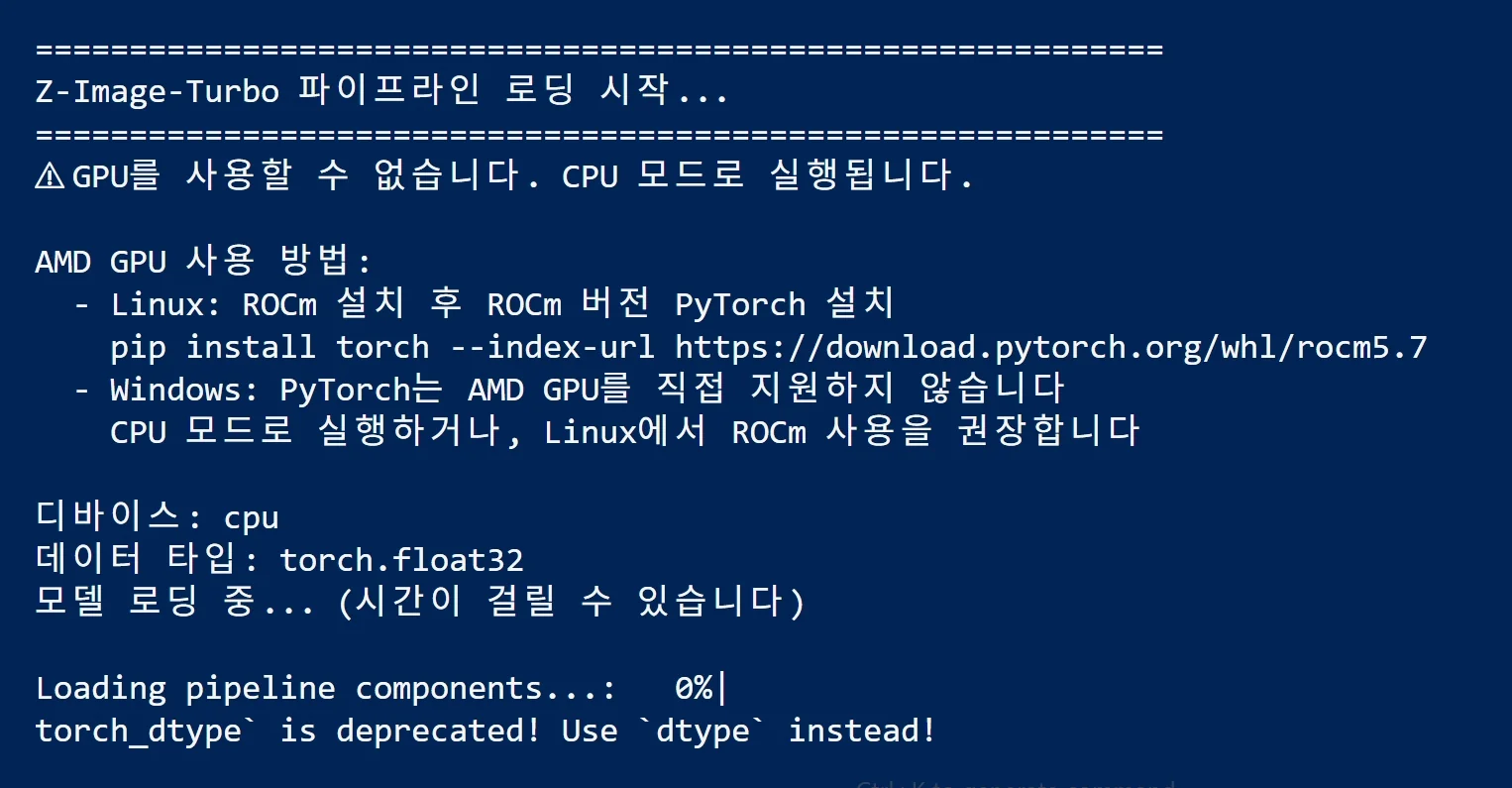

- AMD GPU: AMD GPU로 시도 하시면, 이러한 화면을 자주 보며, 아예 생성이 불가능 합니다. NVidia 가세요...

3. Z-Image Turbo: 저사양에서도 빠른 이미지 생성

1) Z-Image가 주목받는 이유

Z-Image 알리바바 Tongyi Lab에서 개발한 최신 이미지 생성 모델로, 효율성과 품질을 모두 잡은 것이 특징입니다. 특히 Z-Image Turbo는 단 8번의 함수 평가(NFE)만으로 기존 모델들과 동등하거나 더 나은 품질의 이미지를 생성합니다. 16GB VRAM의 소비자용 GPU에서도 1초 이내의 추론 지연시간을 달성하여, 고가의 하드웨어 없이도 실시간에 가까운 이미지 생성이 가능합니다.

- 6B 파라미터 규모의 강력한 모델

- 8 NFE로 빠른 생성 속도 달성

- 16GB VRAM에서 1초 이내 생성 가능

- H800 GPU에서는 서브세컨드(1초 미만) 추론 달성

2) Z-Image의 주요 특징

Z-Image Turbo는 사실적인 이미지 생성에 뛰어나며, 영어와 중국어 텍스트 렌더링을 정확하게 처리합니다. 프롬프트 이해력이 높아서 복잡한 지시사항도 잘 따릅니다. Scalable Single-Stream DiT(S3-DiT) 아키텍처를 채용하여 텍스트, 시각적 의미 토큰, 이미지 VAE 토큰을 하나의 통합된 입력 스트림으로 처리합니다.

- 포토리얼리스틱 이미지 생성 품질 우수

- 영어/중국어 이중 언어 텍스트 렌더링 지원

- 프롬프트 인핸서로 추론 능력 강화

- 단일 스트림 아키텍처로 파라미터 효율성 극대화

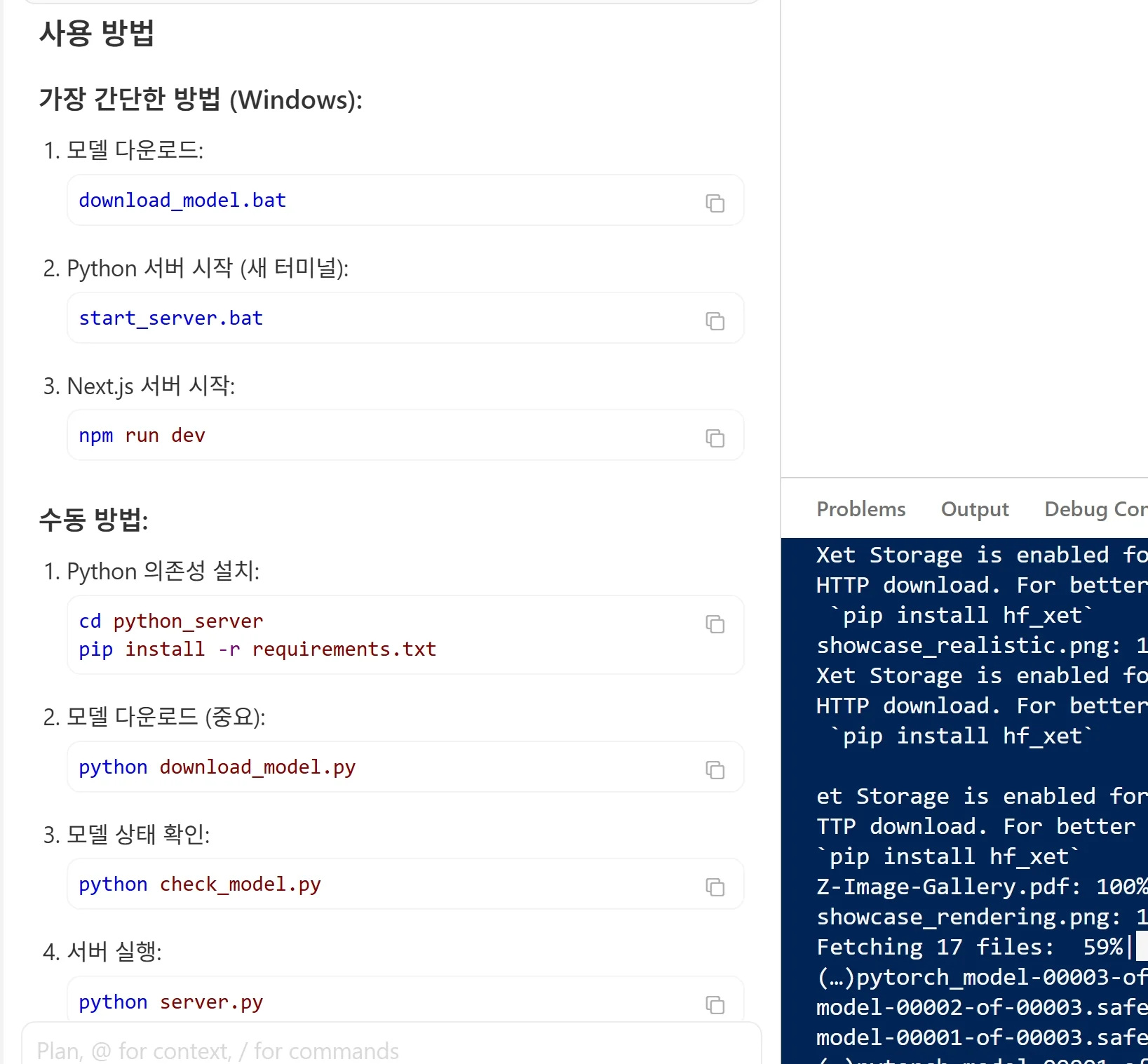

3) Z-Image 설치 및 사용

Z-Image는 Hugging Face의 diffusers 라이브러리를 통해 쉽게 사용할 수 있습니다. 최신 버전의 diffusers를 소스에서 설치해야 하며, ZImagePipeline을 통해 모델을 로드합니다. CPU 오프로딩 기능을 활성화하면 메모리가 제한된 환경에서도 실행 가능합니다.

- diffusers 최신 버전 소스 설치 필요:

pip install git+https://github.com/huggingface/diffusers - bfloat16 정밀도로 최적 성능 발휘

- Flash Attention 2/3 지원으로 효율성 향상

enable_model_cpu_offload()옵션으로 저사양 환경 대응

4) Z-Image 모델 변형

Z-Image 프로젝트는 세 가지 변형 모델을 제공합니다. Turbo는 증류된 버전으로 빠른 생성에 최적화되어 있고, Base는 커뮤니티 파인튜닝을 위한 기반 모델입니다. Edit 버전은 이미지 편집 작업에 특화되어 자연어 프롬프트 기반의 정밀한 편집이 가능합니다.

- Z-Image-Turbo: 8 NFE 빠른 생성, 현재 공개

- Z-Image-Base: 파인튜닝용 기반 모델, 공개 예정

- Z-Image-Edit: 이미지 편집 특화, 공개 예정

- Apache 2.0 라이선스로 상업적 사용 가능

4. 소프트웨어 환경 설정

1) Python 설치

Stable Diffusion과 Z-Image 등 관련 도구들은 Python으로 작성되어 있습니다. Python 3.10.x 버전을 권장하는데, 너무 최신 버전은 일부 라이브러리와 호환성 문제가 있을 수 있습니다. 공식 Python 웹사이트에서 설치 파일을 다운로드하고, 설치 시 "Add Python to PATH" 옵션을 반드시 체크해야 합니다.

- Python 3.10.x 버전 권장 (3.10.6 또는 3.10.11)

- 설치 시 PATH 추가 옵션 필수 체크

- 설치 후 명령 프롬프트에서

python --version으로 확인

2) NVIDIA 드라이버와 CUDA 설치

NVIDIA GPU를 사용하려면 최신 그래픽 드라이버와 CUDA Toolkit이 필요합니다. 드라이버는 NVIDIA 공식 사이트에서 GPU 모델에 맞는 버전을 다운로드합니다. CUDA는 11.8 또는 12.x 버전이 현재 가장 호환성이 좋습니다. cuDNN도 함께 설치해야 하는데, NVIDIA 개발자 계정이 필요합니다.

- NVIDIA 드라이버: 최신 Game Ready 또는 Studio 드라이버

- CUDA Toolkit: 11.8 또는 12.1 버전 권장

- cuDNN: CUDA 버전에 맞는 버전 설치

- 환경 변수 설정이 자동으로 되지 않으면 수동 추가 필요

3) Git 설치

WebUI나 ComfyUI를 설치할 때 Git을 사용하여 저장소를 클론합니다. Git for Windows를 설치하면 Git Bash도 함께 설치되어 리눅스 스타일 명령어를 사용할 수 있습니다. 설치 과정에서 대부분 기본 옵션을 선택하면 됩니다.

- Git for Windows 공식 사이트에서 다운로드

- 설치 시 기본 옵션 유지

- 설치 후

git --version으로 확인

4) 가상환경 이해

Python 프로젝트마다 필요한 라이브러리 버전이 다를 수 있어서 가상환경을 사용합니다. 가상환경은 독립된 Python 환경을 만들어서 라이브러리 충돌을 방지합니다. WebUI 설치 스크립트가 자동으로 가상환경을 생성하지만, 원리를 이해하면 문제 해결에 도움이 됩니다.

- venv: Python 내장 가상환경 도구

- conda: Anaconda/Miniconda 사용 시 가상환경 관리

- 각 프로젝트별로 독립된 환경 유지 권장

5. AUTOMATIC1111 WebUI 설치

1) AUTOMATIC1111 WebUI 소개

AUTOMATIC1111 Stable Diffusion WebUI는 가장 널리 사용되는 Stable Diffusion 인터페이스입니다. 웹 브라우저에서 접근할 수 있는 GUI를 제공하고, txt2img, img2img, 인페인팅, 아웃페인팅 등 다양한 기능을 지원합니다. 확장 기능 시스템이 잘 되어 있어서 ControlNet, LoRA, 다양한 샘플러 등을 쉽게 추가할 수 있습니다.

- 직관적인 웹 기반 인터페이스

- 풍부한 기능과 설정 옵션

- 활발한 커뮤니티와 확장 기능 생태계

2) 설치 과정

설치는 Git을 사용하여 저장소를 클론하고 배치 파일을 실행하는 방식입니다. 먼저 설치할 폴더를 정하고, 해당 위치에서 명령 프롬프트를 엽니다. git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git 명령으로 저장소를 클론합니다. 클론이 완료되면 생성된 폴더로 이동하여 webui-user.bat 파일을 실행합니다.

- 설치 위치: 경로에 한글이나 공백이 없는 곳 권장

- 첫 실행 시 필요한 의존성을 자동으로 다운로드

- 초기 설치에 1030분 소요 (인터넷 속도에 따라 다름)

- 설치 완료 후 브라우저에서

http://127.0.0.1:7860접속

3) 기본 설정과 최적화

설치 후 몇 가지 설정을 조정하면 성능을 개선할 수 있습니다. webui-user.bat 파일을 메모장으로 열어서 COMMANDLINE_ARGS 부분에 옵션을 추가합니다. --xformers 옵션은 메모리 사용량을 줄이고 속도를 높여줍니다. VRAM이 부족한 경우 --medvram 또는 --lowvram 옵션을 사용할 수 있습니다.

--xformers: 메모리 효율 개선, 속도 향상--medvram: 8GB VRAM용 최적화--lowvram: 46GB VRAM용 최적화--autolaunch: 실행 시 자동으로 브라우저 열기

4) 폴더 구조 이해

WebUI 폴더 구조를 이해하면 모델과 확장 기능 관리가 쉬워집니다. models/Stable-diffusion 폴더에 체크포인트 모델 파일을 넣습니다. models/Lora 폴더에는 LoRA 파일을, models/VAE 폴더에는 VAE 파일을 넣습니다. extensions 폴더에는 설치된 확장 기능이 저장됩니다.

models/Stable-diffusion: 메인 체크포인트 모델 (.safetensors, .ckpt)models/Lora: LoRA 파일models/VAE: VAE 파일extensions: 확장 기능outputs: 생성된 이미지 저장 위치

6. ComfyUI 설치 (노드 기반 인터페이스)

1) ComfyUI 소개

ComfyUI는 노드 기반 인터페이스를 제공하는 Stable Diffusion 프론트엔드입니다. AUTOMATIC1111 WebUI보다 학습 곡선이 있지만, 더 세밀한 워크플로우 제어가 가능합니다. 복잡한 파이프라인을 시각적으로 구성할 수 있어서 고급 사용자들이 선호합니다. 메모리 효율도 WebUI보다 좋은 편입니다.

- 노드 기반 시각적 워크플로우

- 더 나은 메모리 효율성

- 복잡한 파이프라인 구성 가능

- 워크플로우 저장 및 공유 용이

2) 설치 과정

ComfyUI도 Git을 사용하여 설치합니다. git clone https://github.com/comfyanonymous/ComfyUI.git 명령으로 저장소를 클론합니다. 클론 후 폴더로 이동하여 run_nvidia_gpu.bat 파일을 실행합니다. 첫 실행 시 필요한 패키지를 자동으로 설치합니다.

- Git clone으로 저장소 다운로드

run_nvidia_gpu.bat실행 (NVIDIA GPU 사용 시)- 기본 포트:

http://127.0.0.1:8188 - 모델 폴더 구조는 WebUI와 유사

3) WebUI vs ComfyUI 선택 기준

초보자라면 AUTOMATIC1111 WebUI로 시작하는 것을 권장합니다. 인터페이스가 직관적이고 튜토리얼이 많습니다. 어느 정도 익숙해지고 더 복잡한 워크플로우가 필요하면 ComfyUI로 전환하거나 병행 사용할 수 있습니다. 두 도구 모두 같은 모델 파일을 사용하므로 모델을 공유할 수 있습니다.

- 초보자: AUTOMATIC1111 WebUI 권장

- 고급 사용자: ComfyUI의 유연성 활용

- 병행 사용: 모델 폴더를 심볼릭 링크로 공유 가능

7. 커스텀 UI 개발: Next.js, React, SQLite 활용

1) 왜 커스텀 UI를 개발하는가

AUTOMATIC1111 WebUI나 ComfyUI는 강력하지만, 특정 워크플로우에 최적화된 인터페이스가 필요할 때가 있습니다. 팀 협업용 도구, 특정 산업에 맞춘 인터페이스, 또는 기존 시스템과의 통합이 필요한 경우 커스텀 UI를 개발하는 것이 효과적입니다. Next.js와 React를 사용하면 현대적이고 반응형인 웹 애플리케이션을 빠르게 구축할 수 있습니다.

- 특정 워크플로우에 최적화된 인터페이스 구축 가능

- 기존 시스템과의 통합 용이

- 팀 협업 기능, 사용자 관리 등 추가 기능 구현

- 브랜딩과 UX를 자유롭게 커스터마이징

2) 기술 스택 구성

프론트엔드는 Next.js와 React를 사용하여 서버 사이드 렌더링과 클라이언트 사이드 인터랙션을 모두 처리합니다. 백엔드 API는 Next.js의 API Routes나 별도의 FastAPI/Flask 서버로 구성할 수 있습니다. 이미지 생성 이력, 프롬프트 저장, 사용자 설정 등을 관리하기 위해 SQLite 데이터베이스를 활용합니다.

- 프론트엔드: Next.js 16+, React 19+, Tailwind CSS

- 상태 관리: Zustand, Jotai, 또는 React Query

- 데이터베이스: SQLite (로컬), Prisma ORM 활용

- AI 백엔드: Python FastAPI + diffusers 라이브러리

3) 아키텍처 설계

전체 시스템은 프론트엔드 웹 애플리케이션, API 서버, AI 추론 서버로 구성됩니다. 프론트엔드에서 사용자가 프롬프트를 입력하면 API 서버를 거쳐 AI 추론 서버로 요청이 전달됩니다. 생성된 이미지는 파일 시스템에 저장되고, 메타데이터는 SQLite에 기록됩니다. 웹소켓을 사용하면 생성 진행 상황을 실시간으로 표시할 수 있습니다.

- 프론트엔드 → API 서버 → AI 추론 서버 구조

- 웹소켓으로 실시간 생성 진행률 표시

- SQLite로 프롬프트 이력, 이미지 메타데이터 관리

- 파일 시스템에 생성된 이미지 저장

4) 구현 예시: 기본 구조

Next.js 프로젝트를 생성하고 필요한 패키지를 설치합니다. Prisma를 사용하여 SQLite 데이터베이스 스키마를 정의하고, API 라우트에서 이미지 생성 요청을 처리합니다. Python 백엔드는 FastAPI로 구성하여 diffusers 파이프라인을 호출합니다.

npx create-next-app@latest로 프로젝트 생성npm install prisma @prisma/client로 ORM 설치prisma init --datasource-provider sqlite로 SQLite 설정- FastAPI 백엔드에서 ZImagePipeline 또는 StableDiffusionPipeline 호출

5) SQLite 스키마 예시

이미지 생성 이력을 관리하기 위한 기본 스키마를 설계합니다. 프롬프트, 네거티브 프롬프트, 생성 파라미터, 이미지 경로, 생성 시간 등을 저장합니다. 이를 통해 이전 생성 결과를 검색하고, 동일한 설정으로 재생성하거나, 프롬프트 분석 등의 기능을 구현할 수 있습니다.

- Image 테이블: id, prompt, negativePrompt, seed, steps, cfgScale, imagePath, createdAt

- Preset 테이블: 자주 사용하는 설정 저장

- Collection 테이블: 이미지 그룹화 관리

- Prisma migrate로 스키마 적용

8. 모델 다운로드와 적용

1) 체크포인트 모델 이해

체크포인트 모델은 Stable Diffusion의 핵심 모델 파일입니다. 학습된 가중치가 담겨 있어서 어떤 스타일의 이미지를 생성할지 결정합니다. 실사 스타일, 애니메이션 스타일, 일러스트 스타일 등 다양한 모델이 공개되어 있습니다. 파일 크기는 보통 27GB 정도입니다.

- .safetensors: 보안이 강화된 최신 형식 (권장)

- .ckpt: 구형 형식, 보안 취약점 가능성

- Civitai, Hugging Face에서 다양한 모델 다운로드 가능

2) 인기 모델 소개

Civitai는 가장 큰 Stable Diffusion 모델 공유 플랫폼입니다. 실사 스타일로는 Realistic Vision, Deliberate, CyberRealistic 등이 인기 있습니다. 애니메이션 스타일로는 Anything, Counterfeit, Meinamix 등이 많이 사용됩니다. SDXL 기반 모델은 더 높은 품질을 제공하지만 VRAM을 더 많이 사용합니다. Z-Image Turbo는 효율성과 품질을 모두 갖춘 최신 대안입니다.

- 실사: Realistic Vision, Deliberate, CyberRealistic

- 애니메이션: Anything, Counterfeit, Meinamix

- SDXL 모델: Juggernaut XL, RealVisXL, Pony Diffusion

- 효율 모델: Z-Image Turbo (16GB VRAM에서 1초 이내 생성)

3) LoRA와 VAE

LoRA(Low-Rank Adaptation)는 기본 모델에 특정 스타일이나 캐릭터를 추가하는 작은 파일입니다. 체크포인트를 교체하지 않고도 다양한 스타일을 적용할 수 있습니다. VAE(Variational Autoencoder)는 이미지의 색상과 디테일에 영향을 주는 컴포넌트입니다. 기본 VAE보다 개선된 VAE를 사용하면 색상이 더 선명해집니다.

- LoRA: 10200MB 크기, 스타일/캐릭터/컨셉 추가

- VAE: 색상 품질 개선, vae-ft-mse-840000-ema-pruned 권장

- Textual Inversion: 특정 컨셉을 텍스트로 호출

4) 모델 적용 방법

다운로드한 모델 파일을 해당 폴더에 복사하면 됩니다. 체크포인트는 models/Stable-diffusion 폴더에, LoRA는 models/Lora 폴더에 넣습니다. WebUI를 재시작하거나 새로고침 버튼을 누르면 새 모델이 목록에 나타납니다. Z-Image는 diffusers를 통해 Hugging Face에서 직접 로드합니다.

- Stable Diffusion 모델: 해당 폴더에 복사 후 UI에서 선택

- Z-Image:

ZImagePipeline.from_pretrained("Tongyi-MAI/Z-Image-Turbo")로 로드 - LoRA는 프롬프트에

<lora:파일명:가중치>형식으로 적용 - 커스텀 UI에서는 API를 통해 모델 전환 구현

9. 이미지 생성 기본 사용법

1) txt2img 기본 사용

txt2img는 텍스트 프롬프트만으로 이미지를 생성하는 기본 기능입니다. 프롬프트 입력창에 원하는 이미지를 설명하는 텍스트를 입력합니다. 영어로 작성하는 것이 결과가 좋고, 쉼표로 키워드를 구분합니다. Negative Prompt에는 원하지 않는 요소를 입력합니다. Z-Image는 영어와 중국어 모두 잘 처리합니다.

- Prompt: 원하는 이미지 설명 (영어 권장, Z-Image는 중국어도 지원)

- Negative Prompt: 피하고 싶은 요소

- 키워드 나열 방식이 효과적: "a beautiful woman, long hair, blue eyes, detailed face"

2) 주요 파라미터 설명

이미지 생성 결과에 영향을 주는 여러 파라미터가 있습니다. Sampling Steps는 이미지 생성 반복 횟수로, 일반 모델은 2030 정도가 적당하고 Z-Image Turbo는 89 스텝으로 충분합니다. CFG Scale은 프롬프트 준수 강도로, 일반 모델은 711 사이가 적당하지만 Z-Image Turbo는 0으로 설정합니다.

- Sampling Steps: 일반 모델 2030, Z-Image Turbo 89

- CFG Scale: 일반 모델 711, Z-Image Turbo 0.0

- Sampler: Euler a, DPM++ 2M Karras 등 다양한 옵션

- Seed: -1은 랜덤, 특정 숫자로 결과 재현 가능

3) 고해상도 이미지 생성

기본 해상도에서 생성한 후 Hires. fix 기능으로 업스케일할 수 있습니다. 처음부터 높은 해상도로 생성하면 구도가 이상해지는 문제가 있어서 2단계 방식을 사용합니다. Z-Image는 기본 1024x1024 해상도를 지원합니다.

- Hires. fix: 2단계 업스케일링

- Denoising strength: 0.50.7 권장

- Upscaler: R-ESRGAN 4x+, SwinIR 4x 등

- Z-Image 기본 해상도: 1024x1024

10. 확장 기능과 고급 활용

1) ControlNet 설치와 활용

ControlNet은 이미지 생성을 더 정밀하게 제어할 수 있게 해주는 확장 기능입니다. 포즈, 깊이 맵, 엣지 등을 참조하여 원하는 구도의 이미지를 생성할 수 있습니다. Extensions 탭에서 URL로 설치하거나 Available 탭에서 검색하여 설치합니다.

- 포즈 제어: OpenPose 모델 사용

- 깊이 제어: Depth 모델로 원근감 유지

- 선화 참조: Canny, Lineart 모델

- 별도의 ControlNet 모델 파일 다운로드 필요

2) img2img와 인페인팅

img2img는 기존 이미지를 기반으로 새 이미지를 생성합니다. 스케치를 완성된 그림으로 변환하거나, 사진의 스타일을 변경하는 데 사용합니다. 인페인팅은 이미지의 특정 부분만 수정하는 기능으로, 마스크를 그려서 해당 영역만 재생성합니다. Z-Image-Edit는 이미지 편집에 특화된 버전으로 곧 공개될 예정입니다.

- img2img: 이미지 스타일 변환, 스케치 완성

- Inpaint: 특정 영역만 수정

- Outpaint: 이미지 영역 확장

- Z-Image-Edit: 자연어 기반 정밀 편집 (공개 예정)

3) 배치 생성과 자동화

여러 이미지를 한 번에 생성하거나 프롬프트를 자동으로 변경하며 생성할 수 있습니다. Batch count와 Batch size를 조절하여 한 번에 여러 장을 생성합니다. 커스텀 UI를 개발하면 대량 생성 작업을 더 효율적으로 관리할 수 있습니다.

- Batch count: 순차적으로 생성할 이미지 수

- Batch size: 동시에 생성할 이미지 수 (VRAM 많이 사용)

- X/Y/Z plot: 파라미터 비교 테스트

- 커스텀 UI: 대량 생성 큐 관리, 스케줄링 기능 구현 가능

11. 문제 해결과 최적화

1) 일반적인 오류와 해결책

CUDA out of memory 오류는 VRAM 부족으로 발생합니다. --medvram 또는 --lowvram 옵션을 추가하거나 해상도를 낮춰야 합니다. Z-Image의 경우 enable_model_cpu_offload() 옵션으로 메모리 제약 환경에서도 실행할 수 있습니다. 모델 로딩 실패는 파일 손상이나 경로 문제일 수 있으니 다시 다운로드하거나 경로를 확인합니다.

- CUDA out of memory: VRAM 부족, 옵션 추가 또는 해상도 낮추기

- 모델 로딩 실패: 파일 손상 또는 경로 문제

- 검은 이미지: VAE 문제, Settings에서 VAE 변경

- 느린 생성 속도: xformers 설치 확인, Flash Attention 활성화

2) 성능 최적화 팁

xformers를 설치하면 메모리 사용량이 줄고 속도가 빨라집니다. Z-Image는 Flash Attention 2/3을 지원하여 더 효율적인 추론이 가능합니다. 모델 컴파일 옵션을 사용하면 첫 실행은 오래 걸리지만 이후 추론 속도가 빨라집니다.

- xformers: Stable Diffusion 필수 설치 권장

- Flash Attention: Z-Image에서

set_attention_backend("flash")설정 - 모델 컴파일:

pipe.transformer.compile()로 추론 가속 - 불필요한 확장 비활성화

3) 모델 관리

모델 파일이 많아지면 관리가 어려워집니다. 폴더를 카테고리별로 정리하고, 사용하지 않는 모델은 별도 저장소로 옮깁니다. 커스텀 UI를 개발한 경우 SQLite에 모델 메타데이터를 저장하여 검색과 필터링을 용이하게 할 수 있습니다.

- 폴더별 분류: 실사, 애니메이션, SDXL, 효율 모델 등

- 사용 빈도 낮은 모델은 외장 저장소로

- 커스텀 UI: 모델 메타데이터 DB 관리

- Hugging Face CLI로 모델 다운로드 자동화:

hf download Tongyi-MAI/Z-Image-Turbo

12. FAQ

Q: 로컬 AI 이미지 생성에 필요한 최소 사양은 무엇인가요? A: 최소 사양으로는 NVIDIA GTX 1660 이상의 GPU(6GB VRAM), 16GB RAM, 100GB 이상의 SSD 여유 공간이 필요합니다. 다만 이 사양에서는 저해상도 이미지만 생성 가능하고 속도도 느립니다. 쾌적한 사용을 위해서는 RTX 3060 12GB 이상, 32GB RAM을 권장합니다. Z-Image Turbo처럼 효율적인 모델을 사용하면 16GB VRAM에서도 1초 이내에 고품질 이미지를 생성할 수 있습니다.

Q: AMD GPU로도 Stable Diffusion을 실행할 수 있나요? A: AMD GPU도 ROCm을 통해 Stable Diffusion을 실행할 수 있지만, 여러 제약이 있습니다. 현재 ROCm은 Linux에서만 공식 지원되고, Windows에서는 DirectML 백엔드를 사용해야 합니다. 호환성 문제가 빈번하고, 일부 기능이 작동하지 않으며, 성능도 동급 NVIDIA GPU 대비 낮습니다. Z-Image 같은 최신 모델의 Flash Attention 최적화도 NVIDIA에서만 완벽히 지원됩니다. 초보자라면 NVIDIA GPU를 강력히 권장합니다.

Q: Z-Image Turbo가 기존 Stable Diffusion보다 좋은 점은 무엇인가요? A: Z-Image 알리바바 Tongyi Lab Z-Image Turbo의 가장 큰 장점은 효율성입니다. 단 8번의 함수 평가(NFE)만으로 고품질 이미지를 생성하여, 16GB VRAM 소비자용 GPU에서도 1초 이내에 이미지를 생성할 수 있습니다. 기존 Stable Diffusion이 2030 스텝이 필요한 것과 비교하면 23배 빠릅니다. 또한 영어와 중국어 텍스트 렌더링을 정확하게 처리하고, 프롬프트 이해력이 뛰어나 복잡한 지시사항도 잘 따릅니다.

Q: Next.js로 커스텀 UI를 개발하면 어떤 이점이 있나요? A: 기존 WebUI나 ComfyUI는 범용적으로 설계되어 있어서, 특정 워크플로우에 최적화하기 어렵습니다. Next.js와 React로 커스텀 UI를 개발하면 팀 협업 기능, 사용자 권한 관리, 기존 시스템과의 통합, 브랜딩 커스터마이징 등을 자유롭게 구현할 수 있습니다. SQLite를 활용하면 프롬프트 이력 관리, 이미지 검색, 즐겨찾기 등의 기능도 쉽게 추가할 수 있습니다.

Q: 모델 파일은 어디서 다운로드하나요?

A: Civitai(civitai.com)가 가장 큰 Stable Diffusion 모델 공유 플랫폼으로, 다양한 체크포인트, LoRA, VAE를 무료로 다운로드할 수 있습니다. Hugging Face도 공식 모델과 커뮤니티 모델을 호스팅하며, Z-Image Turbo도 Hugging Face에서 다운로드할 수 있습니다. hf download Tongyi-MAI/Z-Image-Turbo 명령으로 CLI에서 직접 다운로드할 수 있습니다. 다운로드 시 .safetensors 형식을 선택하는 것이 보안상 안전합니다.

Q: 이미지 한 장 생성하는 데 얼마나 걸리나요? A: 하드웨어와 모델에 따라 크게 다릅니다. Z-Image Turbo는 16GB VRAM GPU에서 1024x1024 해상도 이미지를 1초 이내에 생성합니다. 기존 Stable Diffusion은 RTX 4090에서 512x512 해상도, 20 스텝 기준으로 23초 정도 걸립니다. RTX 3060에서는 같은 조건으로 1015초 정도 소요됩니다. 해상도를 높이거나 스텝 수를 늘리면 시간이 비례해서 증가합니다.

Q: 생성한 이미지의 저작권은 어떻게 되나요? A: AI 생성 이미지의 저작권은 국가별로 법적 해석이 다르고 아직 명확히 정립되지 않은 영역입니다. 일반적으로 순수 AI 생성 이미지는 저작권 보호를 받기 어렵다는 견해가 있습니다. 상업적 사용 시에는 사용한 모델의 라이선스를 확인해야 합니다. Z-Image는 Apache 2.0 라이선스로 상업적 사용이 가능하지만, 일부 Stable Diffusion 모델은 상업적 사용을 제한하거나 크레딧 표기를 요구합니다.

13. 마무리

로컬 AI 이미지 생성 환경 구축은 초기에 시간과 노력이 필요하지만, 한 번 설정하면 무제한으로 이미지를 생성할 수 있는 강력한 도구를 갖게 됩니다. Z-Image Turbo 같은 효율적인 모델의 등장으로 고가의 하드웨어 없이도 빠른 이미지 생성이 가능해졌습니다.

핵심 요약:

- NVIDIA GPU가 호환성과 성능 면에서 최선의 선택이며, 최소 8GB VRAM 이상을 권장

- Z-Image Turbo는 16GB VRAM에서 1초 이내 생성 가능한 효율적인 대안

- AUTOMATIC1111 WebUI는 초보자에게 적합하고, ComfyUI는 고급 사용자에게 더 많은 유연성 제공

- Next.js, React, SQLite로 커스텀 UI를 개발하여 특정 워크플로우에 최적화 가능

- Civitai와 Hugging Face에서 다양한 무료 모델을 다운로드하여 활용 가능

환경 구축 후에는 다양한 모델과 프롬프트를 실험하며 자신만의 워크플로우를 만들어가는 것이 중요합니다. Stable Diffusion 프롬프트 작성법이나 ControlNet 활용 가이드 같은 심화 주제도 함께 학습하면 더 높은 품질의 이미지를 생성할 수 있습니다. 커스텀 UI 개발에 관심이 있다면 Next.js API Routes 가이드와 Prisma ORM 사용법도 참고하면 도움이 됩니다.