AI 채팅 직접 구축 - 중요 API 가격 비교 2026 || 나만의 AI 에이전트 구축을 위한 완벽 가이드

AI 개발을 시작하려는데 어떤 모델을 선택해야 할지 막막하셨나요? 최근 바이브 코딩이 주목받으면서 개발자들이 직접 AI 에이전트를 구축하는 사례가 급증하고 있습니다. 하지만 수백 개의 AI 모델 중에서 가격과 성능을 동시에 고려해 최적의 선택을 하기란 쉽지 않습니다.

이 문서에서는 오픈라우터(OpenRouter)에 등록된 305개 AI 모델의 가격을 체계적으로 분석하고, 용도별로 어떤 모델을 선택해야 하는지 실용적인 가이드를 제공합니다. 무료 모델부터 최고급 프리미엄 모델까지, 당신의 프로젝트에 딱 맞는 AI를 찾아보세요.

환율은 1달러당 1,520원을 기준으로 계산했으며, 모든 가격은 100만 토큰 기준입니다. 실제 프로젝트에서 예산을 산정할 때 바로 활용할 수 있도록 원화 병기로 정리했습니다.

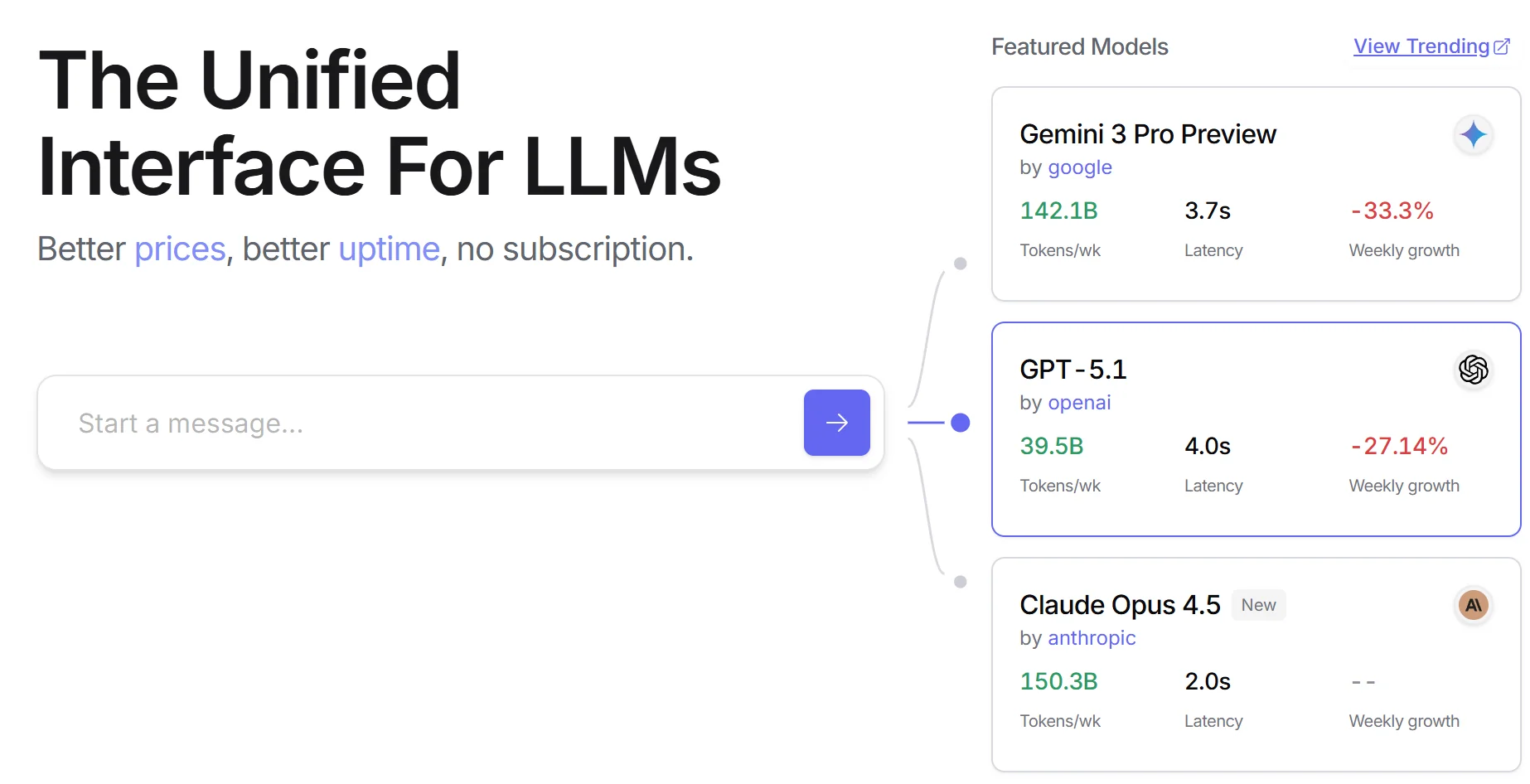

1. 오픈라우터와 AI API 시장 이해하기

1) 오픈라우터가 개발자들에게 인기 있는 이유

오픈라우터(OpenRouter)는 단일 API로 500개 이상의 AI 모델에 접근할 수 있는 통합 플랫폼입니다. 각 AI 제공사마다 별도의 계정을 만들고 API 키를 관리하는 번거로움 없이, 하나의 인터페이스로 OpenAI, Anthropic, Google, Meta, xAI 등 주요 AI 모델을 모두 사용할 수 있습니다. 특히 커서 IDE나 Windsurf 같은 AI 코딩 도구에서 기본 지원하기 때문에 바이브 코딩을 시작하는 개발자들에게 필수 도구가 되었습니다.

가장 큰 장점은 가격 비교와 모델 전환이 자유롭다는 점입니다. 프로젝트 초기에는 무료 모델로 프로토타입을 만들다가, 성능이 필요한 부분에만 프리미엄 모델을 적용하는 식으로 유연하게 운영할 수 있습니다. 또한 각 모델의 실시간 가용성과 응답 속도를 확인할 수 있어 안정적인 서비스 구축이 가능합니다.

무료 계정으로 시작해도 대부분의 무료 모델을 제한 없이 사용할 수 있습니다. 크레딧을 충전하면 유료 모델도 즉시 사용 가능하며, 사용량은 실시간 대시보드에서 모니터링됩니다.

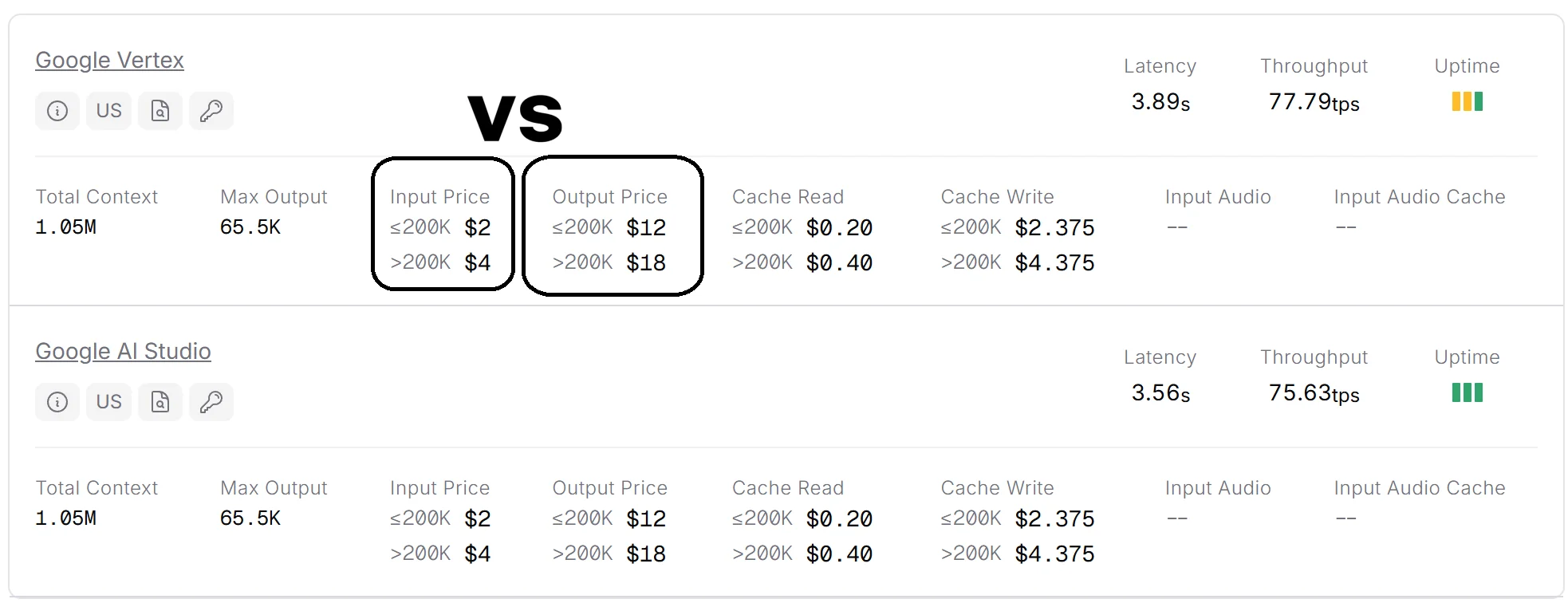

2) AI API 가격 구조 이해하기

AI API는 주로 토큰 단위로 과금됩니다. 토큰은 대략 한글 기준 1-2글자, 영문 기준 4-5글자 정도로 생각하면 됩니다. 입력 토큰과 출력 토큰의 가격이 다른 경우가 많은데, 일반적으로 출력 토큰이 2-5배 비쌉니다. 예를 들어 GPT-4o는 입력 $2.50, 출력 $10으로 출력이 4배 비쌉니다.

컨텍스트 윈도우는 모델이 한 번에 처리할 수 있는 최대 토큰 수를 의미합니다. 긴 문서를 분석하거나 대화 기록을 유지해야 하는 챗봇에서는 큰 컨텍스트가 필요합니다. 최근 모델들은 100만 토큰 이상의 거대한 컨텍스트를 지원하는 추세이며, 이는 전체 코드베이스를 한 번에 분석할 수 있는 수준입니다.

실제 비용 계산 시에는 토큰 수만 고려하면 안 됩니다. 응답 속도, 정확도, 실패율도 중요한 요소입니다. 저렴한 모델이 여러 번 재시도해야 한다면 오히려 비싼 모델을 한 번 쓰는 것이 경제적일 수 있습니다.

3) 2025년 12월 AI 모델 시장 현황

2025년 12월 현재 AI 모델 시장은 성능과 가격 경쟁이 치열합니다. OpenAI, Anthropic, Google 같은 기존 강자들이 계속 새 모델을 출시하는 가운데, xAI의 Grok 시리즈가 빠른 속도와 긴 컨텍스트로 주목받고 있습니다. 소형 경량 모델의 품질도 크게 향상되었으며, Mistral의 Ministral 시리즈나 Google의 Gemma 3 시리즈는 3B-14B 크기로 작지만 실용적인 성능을 제공합니다.

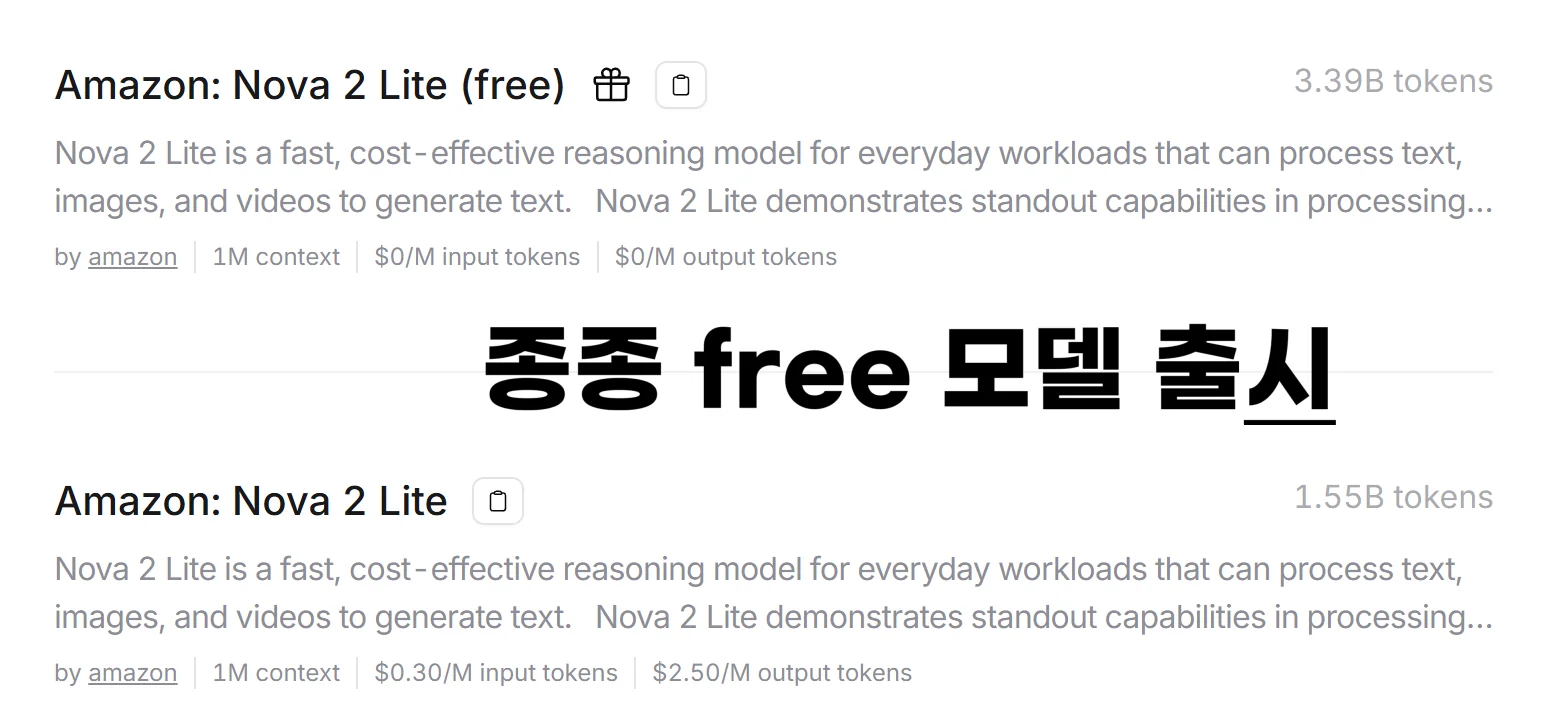

무료 모델도 다양해졌습니다. Amazon Nova 2 Lite, Google Gemini 2.0 Flash Experimental, Meta Llama 3.3 70B 같은 무료 모델들이 실전에서도 충분히 사용 가능한 수준입니다. 개인 개발자나 소규모 스타트업은 무료 모델만으로도 상당한 수준의 서비스를 구축할 수 있게 되었습니다.

특화 모델의 증가도 눈에 띕니다. 코딩 전용, 이미지 분석 전용, 추론 전용 모델들이 각 분야에서 범용 모델보다 뛰어난 성능을 보입니다. 용도에 맞는 특화 모델을 선택하면 비용과 성능 모두에서 이점을 얻을 수 있습니다.

2. 주요 AI 모델 가격표

모델별 가격 비교표

이 표는 오픈 라우터의 AI 모델들의 주요 정보를 정리한 것입니다. 2025년 12월 5일 최신 기준입니다. 입력 및 출력 비용은 100만 토큰 기준이며, 컨텍스트 크기는 각 모델이 한 번에 처리할 수 있는 최대 토큰 수를 나타냅니다. (환율: 1달러 = 1,520원 기준)

- 주요 무료 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Amazon: Nova 2 Lite (free) | $0 (₩0) | $0 (₩0) | 1,000,000 |

| Arcee AI: Trinity Mini (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| TNG: R1T Chimera (free) | $0 (₩0) | $0 (₩0) | 163,840 |

| AllenAI: Olmo 3 32B Think (free) | $0 (₩0) | $0 (₩0) | 65,536 |

| Kwaipilot: KAT-Coder-Pro V1 (free) | $0 (₩0) | $0 (₩0) | 256,000 |

| NVIDIA: Nemotron Nano 12B 2 VL (free) | $0 (₩0) | $0 (₩0) | 128,000 |

| Tongyi DeepResearch 30B A3B (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| Meituan: LongCat Flash Chat (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| NVIDIA: Nemotron Nano 9B V2 (free) | $0 (₩0) | $0 (₩0) | 128,000 |

| Venice: Uncensored (free) | $0 (₩0) | $0 (₩0) | 32,768 |

| Google: Gemma 3n 2B (free) | $0 (₩0) | $0 (₩0) | 8,192 |

| TNG: DeepSeek R1T2 Chimera (free) | $0 (₩0) | $0 (₩0) | 163,840 |

| Google: Gemma 3n 4B (free) | $0 (₩0) | $0 (₩0) | 8,192 |

| Qwen: Qwen3 4B (free) | $0 (₩0) | $0 (₩0) | 40,960 |

| Qwen: Qwen3 235B A22B (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| TNG: DeepSeek R1T Chimera (free) | $0 (₩0) | $0 (₩0) | 163,840 |

| Mistral: Mistral Small 3.1 24B (free) | $0 (₩0) | $0 (₩0) | 128,000 |

| Google: Gemma 3 4B (free) | $0 (₩0) | $0 (₩0) | 32,768 |

| Google: Gemma 3 12B (free) | $0 (₩0) | $0 (₩0) | 32,768 |

| Google: Gemma 3 27B (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| Google: Gemini 2.0 Flash Experimental (free) | $0 (₩0) | $0 (₩0) | 1,048,576 |

| Meta: Llama 3.3 70B Instruct (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| Meta: Llama 3.2 3B Instruct (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| Nous: Hermes 3 405B Instruct (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| Mistral: Mistral 7B Instruct (free) | $0 (₩0) | $0 (₩0) | 32,768 |

| OpenAI: gpt-oss-20b (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| Z.AI: GLM 4.5 Air (free) | $0 (₩0) | $0 (₩0) | 131,072 |

| Qwen: Qwen3 Coder 480B A35B (free) | $0 (₩0) | $0 (₩0) | 262,000 |

| MoonshotAI: Kimi K2 0711 (free) | $0 (₩0) | $0 (₩0) | 32,768 |

- 프리미엄 초대형 모델 (가장 비싼 모델들)

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| OpenAI: o1-pro | $150 (₩228,000) | $600 (₩912,000) | 200,000 |

| OpenAI: GPT-5 Pro | $15 (₩22,800) | $120 (₩182,400) | 400,000 |

| Anthropic: Claude Opus 4.5 | $5 (₩7,600) | $25 (₩38,000) | 200,000 |

| Anthropic: Claude Opus 4.1 | $15 (₩22,800) | $75 (₩114,000) | 200,000 |

| Anthropic: Claude Opus 4 | $15 (₩22,800) | $75 (₩114,000) | 200,000 |

| Anthropic: Claude 3 Opus | $15 (₩22,800) | $75 (₩114,000) | 200,000 |

| OpenAI: o3 Pro | $20 (₩30,400) | $80 (₩121,600) | 200,000 |

| OpenAI: o1 | $15 (₩22,800) | $60 (₩91,200) | 200,000 |

| OpenAI: o3 Deep Research | $10 (₩15,200) | $40 (₩60,800) | 200,000 |

| Amazon: Nova Premier 1.0 | $2.50 (₩3,800) | $12.50 (₩19,000) | 1,000,000 |

| OpenAI: GPT-5 Image | $10 (₩15,200) | $10 (₩15,200) | 400,000 |

| OpenAI: GPT-4 Turbo | $10 (₩15,200) | $30 (₩45,600) | 128,000 |

| Google: Gemini 2.5 Pro | $1.25 (₩1,900) | $10 (₩15,200) | 1,048,576 |

| OpenAI: GPT-5.1 | $1.25 (₩1,900) | $10 (₩15,200) | 400,000 |

| OpenAI: GPT-5 | $1.25 (₩1,900) | $10 (₩15,200) | 400,000 |

- 이미지 생성 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Black Forest Labs: FLUX.2 Flex | $14.64 (₩22,253) | $14.64 (₩22,253) | 67,344 |

| Black Forest Labs: FLUX.2 Pro | $3.66 (₩5,563) | $3.66 (₩5,563) | 46,864 |

| OpenAI: GPT-5 Image | $10 (₩15,200) | $10 (₩15,200) | 400,000 |

| OpenAI: GPT-5 Image Mini | $2.50 (₩3,800) | $2 (₩3,040) | 400,000 |

| Google: Nano Banana Pro | $2 (₩3,040) | $12 (₩18,240) | 65,536 |

| Google: Gemini 3 Pro Image Preview | $2 (₩3,040) | $12 (₩18,240) | 65,536 |

| Google: Gemini 2.5 Flash Image | $0.30 (₩456) | $2.50 (₩3,800) | 32,768 |

- Anthropic Claude 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Anthropic: Claude Opus 4.5 | $5 (₩7,600) | $25 (₩38,000) | 200,000 |

| Anthropic: Claude Opus 4.1 | $15 (₩22,800) | $75 (₩114,000) | 200,000 |

| Anthropic: Claude Opus 4 | $15 (₩22,800) | $75 (₩114,000) | 200,000 |

| Anthropic: Claude Sonnet 4.5 | $3 (₩4,560) | $15 (₩22,800) | 1,000,000 |

| Anthropic: Claude Sonnet 4 | $3 (₩4,560) | $15 (₩22,800) | 1,000,000 |

| Anthropic: Claude 3.7 Sonnet | $3 (₩4,560) | $15 (₩22,800) | 200,000 |

| Anthropic: Claude 3.5 Sonnet | $6 (₩9,120) | $30 (₩45,600) | 200,000 |

| Anthropic: Claude Haiku 4.5 | $1 (₩1,520) | $5 (₩7,600) | 200,000 |

| Anthropic: Claude 3.5 Haiku | $0.80 (₩1,216) | $4 (₩6,080) | 200,000 |

| Anthropic: Claude 3 Haiku | $0.25 (₩380) | $1.25 (₩1,900) | 200,000 |

| Anthropic: Claude 3 Opus | $15 (₩22,800) | $75 (₩114,000) | 200,000 |

- OpenAI GPT 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| OpenAI: o1-pro | $150 (₩228,000) | $600 (₩912,000) | 200,000 |

| OpenAI: GPT-5 Pro | $15 (₩22,800) | $120 (₩182,400) | 400,000 |

| OpenAI: GPT-5.1 | $1.25 (₩1,900) | $10 (₩15,200) | 400,000 |

| OpenAI: GPT-5.1 Chat | $1.25 (₩1,900) | $10 (₩15,200) | 128,000 |

| OpenAI: GPT-5.1-Codex | $1.25 (₩1,900) | $10 (₩15,200) | 400,000 |

| OpenAI: GPT-5 | $1.25 (₩1,900) | $10 (₩15,200) | 400,000 |

| OpenAI: GPT-5 Chat | $1.25 (₩1,900) | $10 (₩15,200) | 128,000 |

| OpenAI: GPT-5 Codex | $1.25 (₩1,900) | $10 (₩15,200) | 400,000 |

| OpenAI: GPT-5.1-Codex-Mini | $0.25 (₩380) | $2 (₩3,040) | 400,000 |

| OpenAI: GPT-5 Mini | $0.25 (₩380) | $2 (₩3,040) | 400,000 |

| OpenAI: GPT-5 Nano | $0.05 (₩76) | $0.40 (₩608) | 400,000 |

| OpenAI: GPT-4.1 | $2 (₩3,040) | $8 (₩12,160) | 1,047,576 |

| OpenAI: GPT-4.1 Mini | $0.40 (₩608) | $1.60 (₩2,432) | 1,047,576 |

| OpenAI: GPT-4.1 Nano | $0.10 (₩152) | $0.40 (₩608) | 1,047,576 |

| OpenAI: GPT-4o | $2.50 (₩3,800) | $10 (₩15,200) | 128,000 |

| OpenAI: GPT-4o Audio | $2.50 (₩3,800) | $10 (₩15,200) | 128,000 |

| OpenAI: ChatGPT-4o | $5 (₩7,600) | $15 (₩22,800) | 128,000 |

| OpenAI: GPT-4o-mini | $0.15 (₩228) | $0.60 (₩912) | 128,000 |

| OpenAI: GPT-3.5 Turbo | $0.50 (₩760) | $1.50 (₩2,280) | 16,385 |

| OpenAI: GPT-4 | $30 (₩45,600) | $60 (₩91,200) | 8,191 |

- OpenAI o-시리즈 (추론 모델)

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| OpenAI: o1-pro | $150 (₩228,000) | $600 (₩912,000) | 200,000 |

| OpenAI: o3 Pro | $20 (₩30,400) | $80 (₩121,600) | 200,000 |

| OpenAI: o1 | $15 (₩22,800) | $60 (₩91,200) | 200,000 |

| OpenAI: o3 Deep Research | $10 (₩15,200) | $40 (₩60,800) | 200,000 |

| OpenAI: o4 Mini Deep Research | $2 (₩3,040) | $8 (₩12,160) | 200,000 |

| OpenAI: o3 | $2 (₩3,040) | $8 (₩12,160) | 200,000 |

| OpenAI: o4 Mini High | $1.10 (₩1,672) | $4.40 (₩6,688) | 200,000 |

| OpenAI: o4 Mini | $1.10 (₩1,672) | $4.40 (₩6,688) | 200,000 |

| OpenAI: o3 Mini High | $1.10 (₩1,672) | $4.40 (₩6,688) | 200,000 |

| OpenAI: o3 Mini | $1.10 (₩1,672) | $4.40 (₩6,688) | 200,000 |

- Google Gemini 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Google: Gemini 3 Pro Preview | $2 (₩3,040) | $12 (₩18,240) | 1,048,576 |

| Google: Gemini 2.5 Pro | $1.25 (₩1,900) | $10 (₩15,200) | 1,048,576 |

| Google: Gemini 2.5 Pro Preview 06-05 | $1.25 (₩1,900) | $10 (₩15,200) | 1,048,576 |

| Google: Gemini 2.5 Pro Preview 05-06 | $1.25 (₩1,900) | $10 (₩15,200) | 1,048,576 |

| Google: Gemini 2.5 Flash | $0.30 (₩456) | $2.50 (₩3,800) | 1,048,576 |

| Google: Gemini 2.5 Flash Preview 09-2025 | $0.30 (₩456) | $2.50 (₩3,800) | 1,048,576 |

| Google: Gemini 2.5 Flash Image | $0.30 (₩456) | $2.50 (₩3,800) | 32,768 |

| Google: Gemini 2.5 Flash Lite | $0.10 (₩152) | $0.40 (₩608) | 1,048,576 |

| Google: Gemini 2.5 Flash Lite Preview 09-2025 | $0.10 (₩152) | $0.40 (₩608) | 1,048,576 |

| Google: Gemini 2.0 Flash | $0.10 (₩152) | $0.40 (₩608) | 1,048,576 |

| Google: Gemini 2.0 Flash Lite | $0.075 (₩114) | $0.30 (₩456) | 1,048,576 |

- DeepSeek 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| DeepSeek: R1 0528 | $0.20 (₩304) | $4.50 (₩6,840) | 163,840 |

| DeepSeek: DeepSeek V3.2 Speciale | $0.27 (₩410) | $0.41 (₩623) | 163,840 |

| DeepSeek: DeepSeek V3.2 | $0.27 (₩410) | $0.40 (₩608) | 163,840 |

| DeepSeek: DeepSeek V3.2 Exp | $0.21 (₩319) | $0.32 (₩486) | 163,840 |

| DeepSeek: DeepSeek V3.1 Terminus | $0.21 (₩319) | $0.79 (₩1,201) | 163,840 |

| DeepSeek: DeepSeek V3.1 | $0.20 (₩304) | $0.80 (₩1,216) | 163,840 |

| DeepSeek: DeepSeek V3 | $0.30 (₩456) | $1.20 (₩1,824) | 163,840 |

| DeepSeek: R1 | $0.30 (₩456) | $1.20 (₩1,824) | 163,840 |

| DeepSeek: DeepSeek Prover V2 | $0.50 (₩760) | $2.18 (₩3,314) | 163,840 |

| DeepSeek: R1 Distill Qwen 32B | $0.24 (₩365) | $0.24 (₩365) | 64,000 |

| DeepSeek: R1 Distill Qwen 14B | $0.12 (₩182) | $0.12 (₩182) | 32,768 |

| DeepSeek: R1 Distill Llama 70B | $0.03 (₩46) | $0.13 (₩198) | 131,072 |

| DeepSeek: R1 0528 Qwen3 8B | $0.02 (₩30) | $0.10 (₩152) | 32,768 |

- Qwen 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Qwen: Qwen3 Max | $1.20 (₩1,824) | $6 (₩9,120) | 256,000 |

| Qwen: Qwen3 Coder Plus | $1 (₩1,520) | $5 (₩7,600) | 128,000 |

| Qwen: Qwen-Max | $1.60 (₩2,432) | $6.40 (₩9,728) | 32,768 |

| Qwen: Qwen VL Max | $0.80 (₩1,216) | $3.20 (₩4,864) | 131,072 |

| Qwen: Qwen Plus 0728 | $0.40 (₩608) | $1.20 (₩1,824) | 1,000,000 |

| Qwen: Qwen Plus 0728 (thinking) | $0.40 (₩608) | $4 (₩6,080) | 1,000,000 |

| Qwen: Qwen-Plus | $0.40 (₩608) | $1.20 (₩1,824) | 131,072 |

| Qwen: Qwen3 Coder Flash | $0.30 (₩456) | $1.50 (₩2,280) | 128,000 |

| Qwen: Qwen3 VL 235B A22B Thinking | $0.30 (₩456) | $1.20 (₩1,824) | 262,144 |

| Qwen: Qwen3 Coder 480B A35B | $0.22 (₩334) | $0.95 (₩1,444) | 262,144 |

| Qwen: Qwen3 VL 235B A22B Instruct | $0.20 (₩304) | $1.20 (₩1,824) | 262,144 |

| Qwen: Qwen3 235B A22B | $0.18 (₩274) | $0.54 (₩821) | 40,960 |

| Qwen: Qwen3 VL 8B Thinking | $0.18 (₩274) | $2.10 (₩3,192) | 256,000 |

| Qwen: Qwen3 VL 30B A3B Thinking | $0.16 (₩243) | $0.80 (₩1,216) | 131,072 |

| Qwen: Qwen3 VL 30B A3B Instruct | $0.15 (₩228) | $0.60 (₩912) | 262,144 |

- 코딩 특화 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| OpenAI: GPT-5.1-Codex | $1.25 (₩1,900) | $10 (₩15,200) | 400,000 |

| OpenAI: GPT-5.1-Codex-Mini | $0.25 (₩380) | $2 (₩3,040) | 400,000 |

| OpenAI: GPT-5 Codex | $1.25 (₩1,900) | $10 (₩15,200) | 400,000 |

| OpenAI: Codex Mini | $1.50 (₩2,280) | $6 (₩9,120) | 200,000 |

| Qwen: Qwen3 Coder Plus | $1 (₩1,520) | $5 (₩7,600) | 128,000 |

| Qwen: Qwen3 Coder Flash | $0.30 (₩456) | $1.50 (₩2,280) | 128,000 |

| Mistral: Codestral 2508 | $0.30 (₩456) | $0.90 (₩1,368) | 256,000 |

| Mistral: Devstral Medium | $0.40 (₩608) | $2 (₩3,040) | 131,072 |

| Mistral: Devstral Small 2505 | $0.06 (₩91) | $0.12 (₩182) | 128,000 |

| Mistral: Devstral Small 1.1 | $0.07 (₩106) | $0.28 (₩426) | 128,000 |

| xAI: Grok Code Fast 1 | $0.20 (₩304) | $1.50 (₩2,280) | 256,000 |

| Arcee AI: Coder Large | $0.50 (₩760) | $0.80 (₩1,216) | 32,768 |

| Inception: Mercury Coder | $0.25 (₩380) | $1 (₩1,520) | 128,000 |

| Qwen: Qwen3 Coder 480B A35B | $0.22 (₩334) | $0.95 (₩1,444) | 262,144 |

| Qwen: Qwen3 Coder 30B A3B Instruct | $0.06 (₩91) | $0.25 (₩380) | 262,144 |

| Qwen2.5 Coder 32B Instruct | $0.03 (₩46) | $0.11 (₩167) | 32,768 |

| Qwen2.5 Coder 7B Instruct | $0.03 (₩46) | $0.09 (₩137) | 32,768 |

- 사고(Thinking/Reasoning) 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| OpenAI: o1-pro | $150 (₩228,000) | $600 (₩912,000) | 200,000 |

| OpenAI: o3 Pro | $20 (₩30,400) | $80 (₩121,600) | 200,000 |

| OpenAI: o1 | $15 (₩22,800) | $60 (₩91,200) | 200,000 |

| DeepSeek: R1 0528 | $0.20 (₩304) | $4.50 (₩6,840) | 163,840 |

| Qwen: Qwen Plus 0728 (thinking) | $0.40 (₩608) | $4 (₩6,080) | 1,000,000 |

| Anthropic: Claude 3.7 Sonnet (thinking) | $3 (₩4,560) | $15 (₩22,800) | 200,000 |

| MoonshotAI: Kimi K2 Thinking | $0.45 (₩684) | $2.35 (₩3,572) | 262,144 |

| Qwen: Qwen3 VL 8B Thinking | $0.18 (₩274) | $2.10 (₩3,192) | 256,000 |

| Qwen: Qwen3 VL 30B A3B Thinking | $0.16 (₩243) | $0.80 (₩1,216) | 131,072 |

| Qwen: Qwen3 VL 235B A22B Thinking | $0.30 (₩456) | $1.20 (₩1,824) | 262,144 |

| Qwen: Qwen3 Next 80B A3B Thinking | $0.12 (₩182) | $1.20 (₩1,824) | 131,072 |

| Qwen: Qwen3 30B A3B Thinking 2507 | $0.051 (₩78) | $0.34 (₩517) | 32,768 |

| Qwen: Qwen3 235B A22B Thinking 2507 | $0.11 (₩167) | $0.60 (₩912) | 262,144 |

| Perplexity: Sonar Reasoning Pro | $2 (₩3,040) | $8 (₩12,160) | 128,000 |

| Perplexity: Sonar Reasoning | $1 (₩1,520) | $5 (₩7,600) | 127,000 |

| Microsoft: Phi 4 Reasoning Plus | $0.07 (₩106) | $0.35 (₩532) | 32,768 |

| Arcee AI: Maestro Reasoning | $0.90 (₩1,368) | $3.30 (₩5,016) | 131,072 |

| THUDM: GLM 4.1V 9B Thinking | $0.028 (₩43) | $0.1104 (₩168) | 65,536 |

| Mistral: Magistral Medium 2506 (thinking) | $2 (₩3,040) | $5 (₩7,600) | 40,960 |

- 멀티모달(비전) 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Google: Gemini 2.5 Flash Image | $0.30 (₩456) | $2.50 (₩3,800) | 32,768 |

| Qwen: Qwen3 VL 8B Thinking | $0.18 (₩274) | $2.10 (₩3,192) | 256,000 |

| Qwen: Qwen3 VL 8B Instruct | $0.064 (₩97) | $0.40 (₩608) | 131,072 |

| Qwen: Qwen3 VL 30B A3B Thinking | $0.16 (₩243) | $0.80 (₩1,216) | 131,072 |

| Qwen: Qwen3 VL 30B A3B Instruct | $0.15 (₩228) | $0.60 (₩912) | 262,144 |

| Qwen: Qwen3 VL 235B A22B Thinking | $0.30 (₩456) | $1.20 (₩1,824) | 262,144 |

| Qwen: Qwen3 VL 235B A22B Instruct | $0.20 (₩304) | $1.20 (₩1,824) | 262,144 |

| Qwen: Qwen2.5 VL 72B Instruct | $0.03 (₩46) | $0.13 (₩198) | 32,768 |

| Qwen: Qwen2.5 VL 32B Instruct | $0.05 (₩76) | $0.22 (₩334) | 16,384 |

| Qwen: Qwen2.5-VL 7B Instruct | $0.20 (₩304) | $0.20 (₩304) | 32,768 |

| Qwen: Qwen VL Max | $0.80 (₩1,216) | $3.20 (₩4,864) | 131,072 |

| Qwen: Qwen VL Plus | $0.21 (₩319) | $0.63 (₩958) | 7,500 |

| Z.AI: GLM 4.5V | $0.48 (₩730) | $1.44 (₩2,189) | 65,536 |

| THUDM: GLM 4.1V 9B Thinking | $0.028 (₩43) | $0.1104 (₩168) | 65,536 |

| Baidu: ERNIE 4.5 VL 424B A47B | $0.336 (₩511) | $1 (₩1,520) | 123,000 |

| Baidu: ERNIE 4.5 VL 28B A3B | $0.112 (₩170) | $0.448 (₩681) | 30,000 |

| Meta: Llama 3.2 90B Vision Instruct | $0.35 (₩532) | $0.40 (₩608) | 32,768 |

| Meta: Llama 3.2 11B Vision Instruct | $0.049 (₩74) | $0.049 (₩74) | 131,072 |

| Microsoft: Phi 4 Multimodal Instruct | $0.05 (₩76) | $0.10 (₩152) | 131,072 |

| Mistral: Pixtral Large 2411 | $2 (₩3,040) | $6 (₩9,120) | 131,072 |

| Mistral: Pixtral 12B | $0.10 (₩152) | $0.10 (₩152) | 32,768 |

| NVIDIA: Nemotron Nano 12B 2 VL | $0.20 (₩304) | $0.60 (₩912) | 131,072 |

| OpenGVLab: InternVL3 78B | $0.15 (₩228) | $0.60 (₩912) | 32,768 |

- 임베딩 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Thenlper: GTE-Base | $0.005 (₩8) | $0 (₩0) | 512 |

| Thenlper: GTE-Large | $0.01 (₩15) | $0 (₩0) | 512 |

| Intfloat: E5-Base-v2 | $0.005 (₩8) | $0 (₩0) | 512 |

| Intfloat: E5-Large-v2 | $0.01 (₩15) | $0 (₩0) | 512 |

| BAAI: bge-base-en-v1.5 | $0.005 (₩8) | $0 (₩0) | 512 |

| BAAI: bge-large-en-v1.5 | $0.01 (₩15) | $0 (₩0) | 512 |

| BAAI: bge-m3 | $0.01 (₩15) | $0 (₩0) | 8,192 |

| Sentence Transformers: all-MiniLM-L6-v2 | $0.005 (₩8) | $0 (₩0) | 512 |

| Qwen: Qwen3 Embedding 8B | $0.01 (₩15) | $0 (₩0) | 32,768 |

| Qwen: Qwen3 Embedding 4B | $0.02 (₩30) | $0 (₩0) | 32,768 |

| OpenAI: Text Embedding 3 Small | $0.02 (₩30) | $0 (₩0) | 8,192 |

| OpenAI: Text Embedding Ada 002 | $0.10 (₩152) | $0 (₩0) | 8,192 |

| OpenAI: Text Embedding 3 Large | $0.13 (₩198) | $0 (₩0) | 8,192 |

| Mistral: Mistral Embed 2312 | $0.10 (₩152) | $0 (₩0) | 8,192 |

| Mistral: Codestral Embed 2505 | $0.15 (₩228) | $0 (₩0) | 8,192 |

| Google: Gemini Embedding 001 | $0.15 (₩228) | $0 (₩0) | 20,000 |

- 저비용 소형 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Meta: Llama 3.2 1B Instruct | $0.027 (₩41) | $0.20 (₩304) | 60,000 |

| Meta: Llama 3.2 3B Instruct | $0.02 (₩30) | $0.02 (₩30) | 131,072 |

| Meta: Llama 3.1 8B Instruct | $0.02 (₩30) | $0.03 (₩46) | 131,072 |

| Mistral: Ministral 3B | $0.04 (₩61) | $0.04 (₩61) | 131,072 |

| Mistral: Ministral 8B | $0.10 (₩152) | $0.10 (₩152) | 131,072 |

| Mistral: Ministral 3 3B 2512 | $0.10 (₩152) | $0.10 (₩152) | 131,072 |

| Mistral: Ministral 3 8B 2512 | $0.15 (₩228) | $0.15 (₩228) | 262,144 |

| Mistral: Ministral 3 14B 2512 | $0.20 (₩304) | $0.20 (₩304) | 262,144 |

| Google: Gemma 3n 4B | $0.02 (₩30) | $0.04 (₩61) | 32,768 |

| Google: Gemma 3 4B | $0.01703 (₩26) | $0.06815 (₩104) | 96,000 |

| Google: Gemma 2 9B | $0.03 (₩46) | $0.09 (₩137) | 8,192 |

| Google: Gemma 3 12B | $0.03 (₩46) | $0.10 (₩152) | 131,072 |

| Arcee AI: Trinity Mini | $0.045 (₩68) | $0.15 (₩228) | 131,072 |

| LiquidAI/LFM2-2.6B | $0.05 (₩76) | $0.10 (₩152) | 32,768 |

| LiquidAI/LFM2-8B-A1B | $0.05 (₩76) | $0.10 (₩152) | 32,768 |

| OpenAI: GPT-5 Nano | $0.05 (₩76) | $0.40 (₩608) | 400,000 |

| AllenAI: Olmo 3 7B Instruct | $0.10 (₩152) | $0.20 (₩304) | 65,536 |

| NVIDIA: Nemotron Nano 9B V2 | $0.04 (₩61) | $0.16 (₩243) | 131,072 |

- 중국산 주요 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| DeepSeek: DeepSeek V3.2 | $0.27 (₩410) | $0.40 (₩608) | 163,840 |

| DeepSeek: R1 | $0.30 (₩456) | $1.20 (₩1,824) | 163,840 |

| Qwen: Qwen3 Max | $1.20 (₩1,824) | $6 (₩9,120) | 256,000 |

| Qwen: Qwen-Max | $1.60 (₩2,432) | $6.40 (₩9,728) | 32,768 |

| Qwen: Qwen Plus 0728 | $0.40 (₩608) | $1.20 (₩1,824) | 1,000,000 |

| Qwen: Qwen3 235B A22B | $0.18 (₩274) | $0.54 (₩821) | 40,960 |

| Z.AI: GLM 4.6 | $0.40 (₩608) | $1.75 (₩2,660) | 202,752 |

| Z.AI: GLM 4.5 | $0.35 (₩532) | $1.55 (₩2,356) | 131,072 |

| Z.AI: GLM 4.5V | $0.48 (₩730) | $1.44 (₩2,189) | 65,536 |

| Z.AI: GLM 4.5 Air | $0.104 (₩158) | $0.68 (₩1,034) | 131,072 |

| Z.AI: GLM 4 32B | $0.10 (₩152) | $0.10 (₩152) | 128,000 |

| MoonshotAI: Kimi K2 Thinking | $0.45 (₩684) | $2.35 (₩3,572) | 262,144 |

| MoonshotAI: Kimi K2 0905 | $0.39 (₩593) | $1.90 (₩2,888) | 262,144 |

| MoonshotAI: Kimi K2 0711 | $0.456 (₩693) | $1.84 (₩2,797) | 131,072 |

| MoonshotAI: Kimi Dev 72B | $0.29 (₩441) | $1.15 (₩1,748) | 131,072 |

| MoonshotAI: Kimi Linear 48B A3B Instruct | $0.50 (₩760) | $0.60 (₩912) | 1,048,576 |

| Baidu: ERNIE 4.5 300B A47B | $0.224 (₩340) | $0.88 (₩1,338) | 123,000 |

| Baidu: ERNIE 4.5 VL 424B A47B | $0.336 (₩511) | $1 (₩1,520) | 123,000 |

| Baidu: ERNIE 4.5 21B A3B | $0.056 (₩85) | $0.224 (₩340) | 120,000 |

| Tencent: Hunyuan A13B Instruct | $0.14 (₩213) | $0.57 (₩866) | 131,072 |

| MiniMax: MiniMax M2 | $0.255 (₩388) | $1.02 (₩1,550) | 204,800 |

| MiniMax: MiniMax M1 | $0.40 (₩608) | $2.20 (₩3,344) | 1,000,000 |

| MiniMax: MiniMax-01 | $0.20 (₩304) | $1.10 (₩1,672) | 1,000,192 |

| StepFun: Step3 | $0.57 (₩866) | $1.42 (₩2,158) | 65,536 |

| Alibaba: Tongyi DeepResearch 30B A3B | $0.09 (₩137) | $0.40 (₩608) | 131,072 |

| Meituan: LongCat Flash Chat | $0.15 (₩228) | $0.75 (₩1,140) | 131,072 |

| ByteDance: UI-TARS 7B | $0.10 (₩152) | $0.20 (₩304) | 128,000 |

- Mistral 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Mistral: Mistral Large 3 2512 | $0.50 (₩760) | $1.50 (₩2,280) | 262,144 |

| Mistral Large 2411 | $2 (₩3,040) | $6 (₩9,120) | 131,072 |

| Mistral Large 2407 | $2 (₩3,040) | $6 (₩9,120) | 131,072 |

| Mistral Large | $2 (₩3,040) | $6 (₩9,120) | 128,000 |

| Mistral: Mistral Medium 3.1 | $0.40 (₩608) | $2 (₩3,040) | 131,072 |

| Mistral: Mistral Medium 3 | $0.40 (₩608) | $2 (₩3,040) | 131,072 |

| Mistral: Mistral Small 3.2 24B | $0.06 (₩91) | $0.18 (₩274) | 131,072 |

| Mistral: Mistral Small 3.1 24B | $0.03 (₩46) | $0.11 (₩167) | 131,072 |

| Mistral: Mistral Small 3 | $0.05 (₩76) | $0.08 (₩122) | 32,768 |

| Mistral: Codestral 2508 | $0.30 (₩456) | $0.90 (₩1,368) | 256,000 |

| Mistral: Devstral Medium | $0.40 (₩608) | $2 (₩3,040) | 131,072 |

| Mistral: Devstral Small 2505 | $0.06 (₩91) | $0.12 (₩182) | 128,000 |

| Mistral: Devstral Small 1.1 | $0.07 (₩106) | $0.28 (₩426) | 128,000 |

| Mistral: Ministral 3 14B 2512 | $0.20 (₩304) | $0.20 (₩304) | 262,144 |

| Mistral: Ministral 3 8B 2512 | $0.15 (₩228) | $0.15 (₩228) | 262,144 |

| Mistral: Ministral 3 3B 2512 | $0.10 (₩152) | $0.10 (₩152) | 131,072 |

| Mistral: Ministral 8B | $0.10 (₩152) | $0.10 (₩152) | 131,072 |

| Mistral: Ministral 3B | $0.04 (₩61) | $0.04 (₩61) | 131,072 |

| Mistral: Pixtral Large 2411 | $2 (₩3,040) | $6 (₩9,120) | 131,072 |

| Mistral: Pixtral 12B | $0.10 (₩152) | $0.10 (₩152) | 32,768 |

| Mistral: Mixtral 8x22B Instruct | $2 (₩3,040) | $6 (₩9,120) | 65,536 |

| Mistral: Mixtral 8x7B Instruct | $0.54 (₩821) | $0.54 (₩821) | 32,768 |

| Mistral: Mistral Nemo | $0.02 (₩30) | $0.04 (₩61) | 131,072 |

| Mistral: Mistral 7B Instruct | $0.028 (₩43) | $0.054 (₩82) | 32,768 |

| Mistral: Saba | $0.20 (₩304) | $0.60 (₩912) | 32,768 |

| Mistral: Magistral Medium 2506 (thinking) | $2 (₩3,040) | $5 (₩7,600) | 40,960 |

- Meta Llama 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Meta: Llama 4 Maverick | $0.136 (₩207) | $0.68 (₩1,034) | 1,048,576 |

| Meta: Llama 4 Scout | $0.08 (₩122) | $0.30 (₩456) | 327,680 |

| Meta: Llama 3.3 70B Instruct | $0.108 (₩164) | $0.32 (₩486) | 131,072 |

| Meta: Llama 3.2 90B Vision Instruct | $0.35 (₩532) | $0.40 (₩608) | 32,768 |

| Meta: Llama 3.2 11B Vision Instruct | $0.049 (₩74) | $0.049 (₩74) | 131,072 |

| Meta: Llama 3.2 3B Instruct | $0.02 (₩30) | $0.02 (₩30) | 131,072 |

| Meta: Llama 3.2 1B Instruct | $0.027 (₩41) | $0.20 (₩304) | 60,000 |

| Meta: Llama 3.1 405B Instruct | $3.50 (₩5,320) | $3.50 (₩5,320) | 130,815 |

| Meta: Llama 3.1 405B (base) | $4 (₩6,080) | $4 (₩6,080) | 32,768 |

| Meta: Llama 3.1 70B Instruct | $0.40 (₩608) | $0.40 (₩608) | 131,072 |

| Meta: Llama 3.1 8B Instruct | $0.02 (₩30) | $0.03 (₩46) | 131,072 |

| Meta: Llama 3 70B Instruct | $0.30 (₩456) | $0.40 (₩608) | 8,192 |

| Meta: Llama 3 8B Instruct | $0.03 (₩46) | $0.06 (₩91) | 8,192 |

| Meta: Llama Guard 4 12B | $0.18 (₩274) | $0.18 (₩274) | 163,840 |

| Meta: LlamaGuard 2 8B | $0.20 (₩304) | $0.20 (₩304) | 8,192 |

| Llama Guard 3 8B | $0.02 (₩30) | $0.06 (₩91) | 131,072 |

- xAI Grok 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| xAI: Grok 4.1 Fast | $0.20 (₩304) | $0.50 (₩760) | 2,000,000 |

| xAI: Grok 4 Fast | $0.20 (₩304) | $0.50 (₩760) | 2,000,000 |

| xAI: Grok 4 | $3 (₩4,560) | $15 (₩22,800) | 256,000 |

| xAI: Grok 3 Beta | $3 (₩4,560) | $15 (₩22,800) | 131,072 |

| xAI: Grok 3 | $3 (₩4,560) | $15 (₩22,800) | 131,072 |

| xAI: Grok 3 Mini Beta | $0.30 (₩456) | $0.50 (₩760) | 131,072 |

| xAI: Grok 3 Mini | $0.30 (₩456) | $0.50 (₩760) | 131,072 |

| xAI: Grok Code Fast 1 | $0.20 (₩304) | $1.50 (₩2,280) | 256,000 |

- Perplexity Sonar 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Perplexity: Sonar Pro Search | $3 (₩4,560) | $15 (₩22,800) | 200,000 |

| Perplexity: Sonar Pro | $3 (₩4,560) | $15 (₩22,800) | 200,000 |

| Perplexity: Sonar Reasoning Pro | $2 (₩3,040) | $8 (₩12,160) | 128,000 |

| Perplexity: Sonar Deep Research | $2 (₩3,040) | $8 (₩12,160) | 128,000 |

| Perplexity: Sonar Reasoning | $1 (₩1,520) | $5 (₩7,600) | 127,000 |

| Perplexity: Sonar | $1 (₩1,520) | $1 (₩1,520) | 127,072 |

- Amazon Nova 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Amazon: Nova Premier 1.0 | $2.50 (₩3,800) | $12.50 (₩19,000) | 1,000,000 |

| Amazon: Nova Pro 1.0 | $0.80 (₩1,216) | $3.20 (₩4,864) | 300,000 |

| Amazon: Nova 2 Lite | $0.30 (₩456) | $2.50 (₩3,800) | 1,000,000 |

| Amazon: Nova Lite 1.0 | $0.06 (₩91) | $0.24 (₩365) | 300,000 |

| Amazon: Nova Micro 1.0 | $0.035 (₩53) | $0.14 (₩213) | 128,000 |

- 기타 특수 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Deep Cogito: Cogito v2.1 671B | $1.25 (₩1,900) | $1.25 (₩1,900) | 128,000 |

| Deep Cogito: Cogito V2 Preview Deepseek 671B | $1.25 (₩1,900) | $1.25 (₩1,900) | 163,840 |

| Deep Cogito: Cogito V2 Preview Llama 405B | $3.50 (₩5,320) | $3.50 (₩5,320) | 32,768 |

| Deep Cogito: Cogito V2 Preview Llama 70B | $0.88 (₩1,338) | $0.88 (₩1,338) | 32,768 |

| Cogito V2 Preview Llama 109B | $0.18 (₩274) | $0.59 (₩897) | 32,767 |

| Prime Intellect: INTELLECT-3 | $0.20 (₩304) | $1.10 (₩1,672) | 131,072 |

| Switchpoint Router | $0.85 (₩1,292) | $3.40 (₩5,168) | 131,072 |

| Relace: Relace Apply 3 | $0.85 (₩1,292) | $1.25 (₩1,900) | 256,000 |

| Morph: Morph V3 Large | $0.90 (₩1,368) | $1.90 (₩2,888) | 262,144 |

| Morph: Morph V3 Fast | $0.80 (₩1,216) | $1.20 (₩1,824) | 81,920 |

| Inception: Mercury | $0.25 (₩380) | $1 (₩1,520) | 128,000 |

| Inception: Mercury Coder | $0.25 (₩380) | $1 (₩1,520) | 128,000 |

| Arcee AI: Virtuoso Large | $0.75 (₩1,140) | $1.20 (₩1,824) | 131,072 |

| Arcee AI: Spotlight | $0.18 (₩274) | $0.18 (₩274) | 131,072 |

| IBM: Granite 4.0 Micro | $0.017 (₩26) | $0.11 (₩167) | 131,000 |

| AI21: Jamba Large 1.7 | $2 (₩3,040) | $8 (₩12,160) | 256,000 |

| AI21: Jamba Mini 1.7 | $0.20 (₩304) | $0.40 (₩608) | 256,000 |

| AionLabs: Aion-1.0 | $4 (₩6,080) | $8 (₩12,160) | 131,072 |

| AionLabs: Aion-1.0-Mini | $0.70 (₩1,064) | $1.40 (₩2,128) | 131,072 |

- 커뮤니티/특수 목적 모델

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| SorcererLM 8x22B | $4.50 (₩6,840) | $4.50 (₩6,840) | 16,000 |

| Magnum v4 72B | $3 (₩4,560) | $5 (₩7,600) | 16,384 |

| Sao10K: Llama 3.1 70B Hanami x1 | $3 (₩4,560) | $3 (₩4,560) | 16,000 |

| Sao10K: Llama 3.3 Euryale 70B | $0.65 (₩988) | $0.75 (₩1,140) | 131,072 |

| Sao10K: Llama 3.1 Euryale 70B v2.2 | $0.65 (₩988) | $0.75 (₩1,140) | 32,768 |

| TheDrummer: Anubis 70B V1.1 | $0.75 (₩1,140) | $1 (₩1,520) | 131,072 |

| TheDrummer: Skyfall 36B V2 | $0.50 (₩760) | $0.80 (₩1,216) | 32,768 |

| TheDrummer: Cydonia 24B V4.1 | $0.30 (₩456) | $0.50 (₩760) | 131,072 |

| TheDrummer: UnslopNemo 12B | $0.40 (₩608) | $0.40 (₩608) | 32,768 |

| TheDrummer: Rocinante 12B | $0.17 (₩258) | $0.43 (₩653) | 32,768 |

| NeverSleep: Lumimaid v0.2 8B | $0.09 (₩137) | $0.60 (₩912) | 32,768 |

| Noromaid 20B | $1 (₩1,520) | $1.75 (₩2,660) | 4,096 |

| Goliath 120B | $6 (₩9,120) | $8 (₩12,160) | 6,144 |

| MythoMax 13B | $0.06 (₩91) | $0.06 (₩91) | 4,096 |

| ReMM SLERP 13B | $0.45 (₩684) | $0.65 (₩988) | 6,144 |

- Cohere 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Cohere: Command A | $2.50 (₩3,800) | $10 (₩15,200) | 256,000 |

| Cohere: Command R+ (08-2024) | $2.50 (₩3,800) | $10 (₩15,200) | 128,000 |

| Cohere: Command R (08-2024) | $0.15 (₩228) | $0.60 (₩912) | 128,000 |

| Cohere: Command R7B (12-2024) | $0.0375 (₩57) | $0.15 (₩228) | 128,000 |

- Microsoft 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Microsoft: MAI DS R1 | $0.30 (₩456) | $1.20 (₩1,824) | 163,840 |

| Microsoft: Phi 4 Reasoning Plus | $0.07 (₩106) | $0.35 (₩532) | 32,768 |

| Microsoft: Phi 4 Multimodal Instruct | $0.05 (₩76) | $0.10 (₩152) | 131,072 |

| Microsoft: Phi 4 | $0.06 (₩91) | $0.14 (₩213) | 16,384 |

| Microsoft: Phi-3.5 Mini 128K Instruct | $0.10 (₩152) | $0.10 (₩152) | 128,000 |

| Microsoft: Phi-3 Medium 128K Instruct | $1 (₩1,520) | $1 (₩1,520) | 128,000 |

| Microsoft: Phi-3 Mini 128K Instruct | $0.10 (₩152) | $0.10 (₩152) | 128,000 |

| WizardLM-2 8x22B | $0.48 (₩730) | $0.48 (₩730) | 65,536 |

- NVIDIA 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| NVIDIA: Llama 3.1 Nemotron Ultra 253B v1 | $0.60 (₩912) | $1.80 (₩2,736) | 131,072 |

| NVIDIA: Llama 3.1 Nemotron 70B Instruct | $1.20 (₩1,824) | $1.20 (₩1,824) | 131,072 |

| NVIDIA: Llama 3.3 Nemotron Super 49B V1.5 | $0.10 (₩152) | $0.40 (₩608) | 131,072 |

| NVIDIA: Nemotron Nano 12B 2 VL | $0.20 (₩304) | $0.60 (₩912) | 131,072 |

| NVIDIA: Nemotron Nano 9B V2 | $0.04 (₩61) | $0.16 (₩243) | 131,072 |

- Nous Research 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| Nous: Hermes 4 405B | $0.30 (₩456) | $1.20 (₩1,824) | 131,072 |

| Nous: Hermes 4 70B | $0.11 (₩167) | $0.38 (₩578) | 131,072 |

| Nous: Hermes 3 405B Instruct | $1 (₩1,520) | $1 (₩1,520) | 131,072 |

| Nous: Hermes 3 70B Instruct | $0.30 (₩456) | $0.30 (₩456) | 65,536 |

| Nous: DeepHermes 3 Mistral 24B Preview | $0.05 (₩76) | $0.20 (₩304) | 32,768 |

| NousResearch: Hermes 2 Pro - Llama-3 8B | $0.025 (₩38) | $0.08 (₩122) | 8,192 |

- AllenAI Olmo 시리즈

| 모델명 | 입력 비용 | 출력 비용 | 컨텍스트 |

|---|---|---|---|

| AllenAI: Olmo 3 7B Think | $0.12 (₩182) | $0.20 (₩304) | 65,536 |

| AllenAI: Olmo 3 7B Instruct | $0.10 (₩152) | $0.20 (₩304) | 65,536 |

| AllenAI: Olmo 2 32B Instruct | $0.05 (₩76) | $0.20 (₩304) | 128,000 |

참고사항:

- 가격은 100만 토큰당 미국 달러($) 및 한국 원화(₩) 기준입니다 (환율: $1 = ₩1,520)

- 컨텍스트는 모델이 한 번에 처리할 수 있는 최대 토큰 수입니다

- "(free)" 표시가 있는 모델은 무료로 사용 가능하지만 제한사항이 있을 수 있습니다

- "(exacto)" 버전은 더 정확한 출력을 제공하지만 비용이 더 높습니다

- "(thinking)" 버전은 추론 과정을 표시하는 사고 모델입니다

- 임베딩 모델은 출력 비용이 $0입니다 (벡터 생성만 수행)

- 이미지 생성 모델의 가격은 이미지당 비용이 아닌 토큰당 비용입니다

- 일부 모델은 할인이 적용되어 표시된 가격보다 저렴할 수 있습니다

3. 무료로 시작하는 AI 개발 - 2025년 12월 최신 추천

1) 오픈라우터 무료 모델 필터로 시작하기

오픈라우터 웹사이트에서 모델 목록 페이지에 들어가면 'Free' 필터가 있습니다. 이 필터를 활성화하면 현재 사용 가능한 모든 무료 모델이 표시됩니다. 2025년 12월 5일 기준으로 29개의 완전 무료 모델이 제공되고 있으며, 이 중 최신 모델들을 우선 추천합니다.

Amazon Nova 2 Lite (free)는 2025년 12월 출시된 최신 모델로 100만 토큰 컨텍스트를 무료로 제공합니다. 범용 작업에서 준수한 성능을 보이며, 긴 문서 처리에 특히 유용합니다. 한국어 지원도 양호한 편이며, 초보자가 실습하기에 적합합니다.

Google Gemini 2.0 Flash Experimental (free)는 가장 강력한 무료 모델입니다. 100만 토큰 이상의 거대 컨텍스트와 빠른 응답 속도가 장점입니다. 프로토타입 개발부터 실제 서비스까지 폭넓게 활용할 수 있으며, 멀티모달 처리도 가능합니다. 모델 ID는 google/gemini-2.0-flash-exp:free입니다.

2) 입문자를 위한 무료 모델 추천 순위

처음 시작한다면 Google Gemini 2.0 Flash Experimental (free)을 가장 추천합니다. 최신 모델이면서 성능과 안정성이 검증되었고, 한국어 처리 능력이 뛰어납니다. 멀티모달 기능까지 지원해 텍스트와 이미지를 함께 처리할 수 있어 활용도가 높습니다.

코딩 학습이 목적이라면 Kwaipilot: KAT-Coder-Pro V1 (free)를 사용하세요. 25만 토큰 컨텍스트로 큰 코드베이스도 처리할 수 있으며, 코드 생성과 디버깅에 특화되어 있습니다. 커서 IDE에서 이 모델을 설정하면 무료로 AI 코딩 어시스턴트를 사용할 수 있습니다.

대화형 애플리케이션을 만든다면 Meta Llama 3.3 70B Instruct (free)가 좋습니다. 대화 맥락을 잘 이해하고 자연스러운 응답을 생성합니다. 13만 토큰 컨텍스트로 긴 대화도 충분히 처리할 수 있습니다.

3) 무료 모델의 한계와 주의사항

무료 모델에는 속도 제한(Rate Limit)이 있습니다. 분당 또는 시간당 요청 횟수가 제한되므로, 개발 초기에는 문제없지만 사용자가 늘어나면 유료 전환을 고려해야 합니다. 대시보드에서 실시간 사용량을 모니터링하고 제한에 근접하면 알림을 받도록 설정하세요.

무료 모델은 가용성이 보장되지 않습니다. 서버 부하가 높을 때 일시적으로 사용 불가능하거나 응답이 느려질 수 있습니다. 이는 치명적인 문제가 될 수 있으므로, 상용 서비스에서는 반드시 폴백(Fallback) 전략이 필요합니다. 기본 모델이 실패하면 자동으로 다른 모델로 전환하는 로직을 구현해야 합니다.

무료 모델은 예고 없이 중단되거나 유료로 전환될 수 있습니다. 특정 무료 모델에만 의존하는 것은 위험하므로, 여러 모델을 지원하는 유연한 아키텍처를 설계하는 것이 중요합니다. 코드에서 모델 ID를 하드코딩하지 말고 설정 파일로 관리하세요.

4. 연습과 간단한 서비스 구축 - 100만 토큰당 $0.50 미만 모델

1) 초보자 추천 모델 - $0.10 이하 (₩152 이하)

Mistral: Ministral 3B ($0.04/₩61)는 가장 저렴한 고품질 모델입니다. 30억 파라미터의 작은 크기지만 빠른 응답 속도와 준수한 성능을 제공합니다. 간단한 텍스트 생성, 요약, 분류 작업에 적합하며, 실시간 애플리케이션에서 유용합니다. 컨텍스트는 131,072 토큰으로 충분히 큽니다.

Meta: Llama 3.2 3B Instruct ($0.02/₩30)는 입출력 가격이 동일해 비용 예측이 쉽습니다. 메타의 최신 소형 모델로 오픈소스 커뮤니티에서 검증되었으며, 다양한 언어와 작업을 지원합니다. 13만 토큰 컨텍스트로 긴 대화나 문서도 처리할 수 있습니다.

Google: Gemma 3n 4B ($0.02 입력, $0.04 출력/₩30, ₩61)는 구글의 최신 소형 모델입니다. Gemma 시리즈는 효율성과 안전성에 중점을 두고 설계되었으며, 유해 콘텐츠 필터링이 강력합니다. 교육용 앱이나 가족 친화적인 서비스에 적합합니다.

2) 중급 모델 - $0.10~$0.50 (₩152~₩760)

Mistral: Ministral 3 8B 2512 ($0.15/₩228)는 2025년 12월 출시된 최신 소형 모델입니다. 80억 파라미터로 26만 토큰 컨텍스트를 지원하며, 입출력 가격이 동일해 비용 예측이 쉽습니다. 실시간 채팅, 콘텐츠 생성, 데이터 분석 등 다양한 용도로 활용할 수 있습니다.

Mistral: Ministral 3 14B 2512 ($0.20/₩304)는 더 강력한 성능이 필요할 때 선택하는 모델입니다. 140억 파라미터로 26만 토큰 컨텍스트를 지원하며, 복잡한 추론과 긴 문서 처리에 적합합니다. 가격 대비 성능이 뛰어나 실무에서도 충분히 사용 가능합니다.

xAI: Grok 4.1 Fast ($0.20 입력, $0.50 출력/₩304, ₩760)는 xAI의 최신 고속 모델입니다. 200만 토큰이라는 업계 최대급 컨텍스트를 지원해 초대형 문서나 전체 코드베이스를 한 번에 처리할 수 있습니다. 빠른 응답 속도와 긴 컨텍스트가 필요한 작업에 최적입니다.

3) 이 가격대 모델로 만들 수 있는 것들

챗봇과 고객 지원 시스템을 구축할 수 있습니다. Ministral 3 8B로 기본 응답을 처리하고, 복잡한 질문만 프리미엄 모델로 에스컬레이션하는 구조를 만들면 월 수백만 원의 인건비를 절감할 수 있습니다. 컨텍스트 윈도우가 크므로 이전 대화 기록을 유지하면서 자연스러운 대화가 가능합니다.

콘텐츠 자동화 도구도 가능합니다. 블로그 초안 작성, 소셜 미디어 포스트 생성, 이메일 자동 응답, 상품 설명 작성 등을 자동화할 수 있습니다. Gemma 3n 4B 같은 저가 모델로도 충분히 퀄리티 있는 콘텐츠를 생성할 수 있으며, 월 $10-50 예산으로 수천 개의 콘텐츠를 만들 수 있습니다.

초대형 문서 분석 시스템도 구축 가능합니다. Grok 4.1 Fast의 200만 토큰 컨텍스트를 활용하면 법률 문서, 학술 논문, 기술 매뉴얼 같은 방대한 자료를 한 번에 분석하고 요약할 수 있습니다. 연구자나 변호사 같은 전문직 종사자를 위한 도구로 활용할 수 있습니다.

5. 프로덕션 서비스를 위한 프리미엄 모델

1) Anthropic Claude 시리즈 - 안전성과 신뢰성

Claude는 기업용 AI의 표준으로 자리잡았습니다. Claude Sonnet 4.5 ($3 입력, $15 출력/₩4,560, ₩22,800)는 최신 모델로 100만 토큰 컨텍스트를 지원합니다. 긴 문서 분석, 법률 검토, 의료 기록 처리 같은 전문 분야에서 탁월한 성능을 보입니다.

Claude의 강점은 안전성입니다. 유해 콘텐츠를 잘 거부하고, 민감한 정보를 적절히 처리하며, 예측 가능한 응답을 제공합니다. 고객 대면 서비스에서 브랜드 이미지를 지키면서도 유용한 도움을 줄 수 있습니다. 금융, 의료, 법률 같은 규제 산업에서 특히 선호됩니다.

Claude Haiku 4.5 ($1 입력, $5 출력/₩1,520, ₩7,600)는 빠른 응답이 필요한 실시간 애플리케이션에 적합합니다. Sonnet보다 저렴하면서도 대부분의 작업을 잘 처리합니다. 채팅, 번역, 간단한 분석 작업에서는 Haiku로도 충분하며, 복잡한 작업만 Sonnet으로 처리하는 하이브리드 구조를 추천합니다.

2) xAI Grok 시리즈 - 초대형 컨텍스트의 강자

xAI: Grok 4 Fast ($0.20 입력, $0.50 출력/₩304, ₩760)는 200만 토큰 컨텍스트를 지원하는 고속 모델입니다. 전체 코드베이스, 대규모 데이터셋, 장편 소설 같은 초대형 자료를 한 번에 처리할 수 있습니다. 가격도 합리적이어서 대량 문서 처리가 필요한 비즈니스에 적합합니다.

xAI: Grok 4 ($3 입력, $15 출력/₩4,560, ₩22,800)는 프리미엄 모델로 더 강력한 추론 능력을 제공합니다. 복잡한 분석, 전략 수립, 창의적 작업에서 Claude나 GPT-4o와 비슷한 수준의 성능을 보입니다. 256,000 토큰 컨텍스트로 대부분의 작업을 충분히 처리할 수 있습니다.

xAI: Grok 3 Mini ($0.30 입력, $0.50 출력/₩456, ₩760)는 중급 가격대에서 탁월한 선택입니다. 13만 토큰 컨텍스트와 빠른 응답 속도로 실시간 서비스에 적합하며, 한국어 처리도 준수한 편입니다. 스타트업이 프리미엄 성능을 합리적인 가격에 사용하기 좋습니다.

3) Google Gemini와 OpenAI GPT 시리즈

Google Gemini 2.5 Pro ($1.25 입력, $10 출력/₩1,900, ₩15,200)는 텍스트, 이미지, 비디오, 오디오를 모두 처리할 수 있는 진정한 멀티모달 모델입니다. 100만 토큰 이상의 거대 컨텍스트로 전체 영화 스크립트나 대규모 코드베이스를 한 번에 분석할 수 있습니다. 교육 플랫폼, 콘텐츠 제작 도구, 복합 데이터 분석 시스템에서 Gemini의 멀티모달 능력이 빛을 발합니다.

Google Gemini 2.5 Flash ($0.30 입력, $2.50 출력/₩456, ₩3,800)는 Pro의 경량화 버전이지만 성능은 여전히 강력합니다. 빠른 응답 속도와 합리적인 가격으로 실시간 서비스에 적합하며, 대부분의 멀티모달 작업을 처리할 수 있습니다. 스타트업이 프리미엄 서비스를 구축할 때 가장 많이 선택하는 모델입니다.

OpenAI GPT-4o ($2.50 입력, $10 출력/₩3,800, ₩15,200)는 가장 널리 사용되는 범용 모델입니다. 방대한 커뮤니티와 문서, 튜토리얼이 있어 문제 해결이 쉽고, 대부분의 AI 도구와 잘 통합됩니다. 한국어 처리 능력도 최상급이며, 크리에이티브 작업에서 특히 강합니다.

6. 폴백 전략과 안정적인 서비스 구축

1) 폴백(Fallback) 전략의 중요성

AI 모델은 완벽하게 안정적이지 않습니다. 서버 과부하, 네트워크 오류, 모델 업데이트, 예산 초과 등 다양한 이유로 요청이 실패할 수 있습니다. 특히 무료 모델은 가용성이 보장되지 않아 언제든 사용 불가능해질 수 있습니다. 유료 모델로 전환하는 과정에서도 일시적인 중단이 발생할 수 있습니다.

폴백 전략은 기본 모델이 실패했을 때 자동으로 대체 모델을 시도하는 메커니즘입니다. 이는 서비스 가용성을 크게 향상시키며, 사용자 경험을 보호합니다. 상용 서비스에서는 필수적인 기능이며, 개발 초기부터 구현하는 것이 좋습니다.

폴백 전략 없이 단일 모델에만 의존하면 큰 리스크가 있습니다. 모델이 갑자기 중단되거나 가격이 급등하면 서비스 전체가 마비될 수 있습니다. 여러 모델을 지원하는 유연한 아키텍처를 설계하면 이런 위험을 최소화할 수 있습니다.

2) 기본 폴백 로직 구현 방법

가장 간단한 폴백 전략은 순차적 시도입니다. 우선순위가 높은 모델부터 시도하고, 실패하면 다음 모델을 시도하는 방식입니다. 예를 들어 무료 모델을 먼저 시도하고, 실패하면 저가 유료 모델을, 그것도 실패하면 프리미엄 모델을 사용합니다.

# 폴백 로직 예시 (Python)

models = [ "google/gemini-2.0-flash-exp:free", # 1순위: 무료 모델 "mistralai/ministral-8b-2512", # 2순위: 저가 모델 "anthropic/claude-haiku-4.5", # 3순위: 프리미엄 모델

] def call_ai_with_fallback(prompt, models): for model_id in models: try: response = openrouter_api.call(model_id, prompt) return response except Exception as e: print(f"모델 {model_id} 실패: {e}") continue raise Exception("모든 폴백 모델 실패")

오류 유형에 따른 조건부 폴백도 효과적입니다. 속도 제한 오류는 다른 모델로 전환하고, 일시적 네트워크 오류는 재시도하는 식입니다. 각 오류 코드에 맞는 적절한 대응을 정의하면 성공률을 높일 수 있습니다.

# 오류 유형별 폴백 로직

def smart_fallback(prompt, primary_model, fallback_models): try: return openrouter_api.call(primary_model, prompt) except RateLimitError: # 속도 제한: 즉시 다음 모델로 return call_ai_with_fallback(prompt, fallback_models) except NetworkError: # 네트워크 오류: 3번 재시도 후 폴백 for i in range(3): time.sleep(2 ** i) # 지수 백오프 try: return openrouter_api.call(primary_model, prompt) except NetworkError: continue return call_ai_with_fallback(prompt, fallback_models) except ModelUnavailableError: # 모델 사용 불가: 즉시 폴백 return call_ai_with_fallback(prompt, fallback_models)

3) 고급 폴백 전략과 모니터링

로드 밸런싱 방식의 폴백도 가능합니다. 여러 모델을 동시에 사용하되, 각 요청을 가용 상태와 응답 속도에 따라 분산합니다. 한 모델이 느리거나 실패하면 자동으로 다른 모델로 트래픽이 전환됩니다.

실시간 모니터링을 통해 각 모델의 성공률, 응답 속도, 비용을 추적하세요. 특정 모델의 실패율이 높아지면 자동으로 우선순위를 낮추고, 다른 모델을 더 많이 사용하도록 조정합니다. 이를 통해 서비스 가용성을 99% 이상으로 유지할 수 있습니다.

# 모니터링과 동적 우선순위 조정

class ModelManager: def __init__(self): self.models = { "gemini-free": {"priority": 1, "success_rate": 0.95}, "ministral-8b": {"priority": 2, "success_rate": 0.98}, "claude-haiku": {"priority": 3, "success_rate": 0.99}, } def get_best_model(self): # 성공률 기반 정렬 sorted_models = sorted( self.models.items(), key=lambda x: (-x[1]["success_rate"], x[1]["priority"]) ) return sorted_models[0][0] def record_result(self, model_id, success): # 성공률 업데이트 (이동 평균) current = self.models[model_id]["success_rate"] self.models[model_id]["success_rate"] = ( current * 0.9 + (1 if success else 0) * 0.1 )

비용 기반 폴백도 중요합니다. 예산이 초과될 것 같으면 자동으로 저가 모델로 전환하거나, 특정 사용자에게만 프리미엄 모델을 제공하는 식으로 운영할 수 있습니다. 대시보드에서 실시간 비용을 모니터링하고 알림을 설정하세요.

7. 용도별 최적 모델 선택 전략

1) 바이브 코딩을 위한 모델 선택

커서 IDE나 Windsurf에서 바이브 코딩을 할 때는 작업 유형에 따라 모델을 전환하는 것이 효율적입니다. 일반적인 코드 작성과 자동완성에는 Claude Sonnet 4 ($3 입력, $15 출력/₩4,560, ₩22,800)나 GPT-4o ($2.50 입력, $10 출력/₩3,800, ₩15,200)를 추천합니다. 두 모델 모두 코드 문맥을 잘 이해하고 실용적인 제안을 제공합니다.

대규모 코드베이스 분석이나 리팩토링에는 Grok 4 Fast ($0.20 입력, $0.50 출력/₩304, ₩760)가 최고입니다. 200만 토큰 컨텍스트로 전체 프로젝트를 한 번에 로드하고 분석할 수 있습니다. 레거시 코드를 현대적인 패턴으로 전환하거나, 여러 파일에 걸친 의존성을 파악하는 작업에 특히 유용합니다.

비용을 절약하고 싶다면 무료 모델부터 시작하세요. Google Gemini 2.0 Flash Experimental (free)나 Kwaipilot KAT-Coder-Pro V1 (free)로도 충분히 생산적인 코딩이 가능합니다. 익숙해진 후 프리미엄 모델로 업그레이드해도 늦지 않습니다. 폴백 설정을 잘하면 무료 모델을 기본으로 쓰다가 실패 시에만 유료 모델로 전환할 수 있습니다.

2) 챗봇과 고객 지원 시스템

고객 대면 챗봇에는 안전성과 일관성이 중요합니다. Claude Haiku 4.5 ($1 입력, $5 출력/₩1,520, ₩7,600)는 빠른 응답과 안정적인 품질로 실시간 채팅에 최적입니다. 유해 콘텐츠를 잘 필터링하고 브랜드 톤을 일관되게 유지합니다.

다국어 지원이 필요하다면 Gemini 2.5 Flash ($0.30 입력, $2.50 출력/₩456, ₩3,800)가 좋습니다. 100개 이상의 언어를 지원하며 번역 품질이 우수합니다. 글로벌 서비스를 운영하거나 외국인 고객이 많은 비즈니스에 적합합니다.

예산이 제한적이라면 계층형 구조와 폴백을 함께 사용하세요. 첫 분류는 Ministral 3 8B ($0.15/₩228)로 처리하고, 간단한 FAQ는 무료 모델로, 복잡한 질문만 프리미엄 모델로 에스컬레이션합니다. 각 단계에서 폴백 모델을 설정하면 안정성을 유지하면서도 비용을 80% 이상 절감할 수 있습니다.

3) 대용량 문서 분석과 연구 도구

법률 문서, 학술 논문, 기술 매뉴얼 같은 초대형 자료를 다룬다면 Grok 4.1 Fast ($0.20 입력, $0.50 출력/₩304, ₩760)가 최적입니다. 200만 토큰 컨텍스트로 수백 페이지 분량을 한 번에 분석하고 요약할 수 있습니다. 가격도 합리적이어서 연구자나 변호사 같은 전문직 종사자를 위한 도구로 활용하기 좋습니다.

복잡한 추론과 비교 분석이 필요하다면 Gemini 2.5 Pro ($1.25 입력, $10 출력/₩1,900, ₩15,200)를 추천합니다. 100만 토큰 컨텍스트와 강력한 추론 능력으로 여러 문서를 교차 참조하고 인사이트를 도출할 수 있습니다.

폴백 전략으로는 Grok 4.1 Fast를 1순위로, 실패 시 Gemini 2.5 Flash를 2순위로 설정하세요. 두 모델 모두 100만 토큰 이상의 컨텍스트를 지원해 대부분의 문서를 처리할 수 있으며, 가격대도 합리적입니다.

8. 한국 서비스 개발 시 주의사항

1) 데이터 주권과 개인정보보호법 준수

한국에서 서비스를 운영한다면 개인정보보호법과 데이터 현지화 규정을 반드시 준수해야 합니다. 사용자 데이터를 AI 모델로 처리할 때는 데이터의 저장 위치, 전송 경로, 보관 기간 등을 명확히 관리해야 합니다. 특히 민감한 개인정보(주민등록번호, 의료 정보, 금융 정보)를 다룬다면 더욱 엄격한 기준이 적용됩니다.

미국 기반 서비스인 OpenAI, Anthropic, Google, xAI의 모델들은 데이터가 미국 서버를 거치게 됩니다. 이는 법적으로 허용되지만, 사용자에게 개인정보의 국외 이전에 대한 동의를 받아야 합니다. 서비스 약관과 개인정보 처리방침에 이를 명시하고, 사용자 동의를 받는 프로세스를 구축하세요.

오픈라우터는 유럽에도 서버가 있어 GDPR 준수가 가능합니다. 한국 사용자 데이터를 처리할 때는 가능한 한 유럽 리전을 사용하거나, 민감한 데이터는 로컬에서 전처리 후 익명화하여 AI 모델에 전송하는 방법을 고려하세요.

2) 중국산 모델 사용 시 고려사항

DeepSeek, Qwen, GLM, Baidu ERNIE 같은 중국산 모델은 가격 대비 성능이 매우 뛰어나지만, 한국 서비스에 사용할 때는 신중한 판단이 필요합니다. 무조건 사용을 배제하기보다는 서버 위치와 데이터 처리 경로를 확인하고 프로젝트 성격에 따라 선별적으로 사용하는 것이 바람직합니다.

중국산 모델을 사용하기 전에 반드시 확인해야 할 것은 데이터가 어느 서버를 거치는지입니다. 일부 중국 AI 기업들은 글로벌 서비스를 위해 미국이나 유럽에 서버를 두고 있으며, 이 경우 중국 본토를 거치지 않아 상대적으로 안전합니다. 오픈라우터를 통해 사용할 경우 데이터 라우팅 경로를 확인하고, 가능하다면 유럽 리전을 선택하세요.

다만 현실적으로 중국산 모델에 대한 대중의 인식이 좋지 않은 것은 사실입니다. 중국의 국가정보법에 따라 중국 정부가 데이터 접근을 요구할 수 있다는 우려가 존재하며, 이는 고객 신뢰도에 영향을 줄 수 있습니다. 특히 금융, 의료, 공공, 국방 분야처럼 민감한 정보를 다루는 서비스에서는 고객사의 보안 정책상 중국산 모델 사용이 금지되는 경우가 많습니다.

프로젝트 성격에 따라 선별적으로 사용하는 것을 권장합니다. 개인 프로젝트, 내부 도구 개발, 공개된 데이터만 처리하는 서비스라면 가성비를 고려해 중국산 모델을 적극 활용할 수 있습니다. 반면 B2B 서비스나 개인정보를 다루는 서비스라면 계약 전에 고객사의 정책을 확인하고, 필요하다면 미국이나 유럽 모델을 기본으로 사용하세요. 폴백 전략에서 중국산 모델을 하위 순위로 배치하는 것도 좋은 절충안입니다.

3) 한국어 지원이 우수한 모델 선택

한국 사용자를 대상으로 하는 서비스라면 한국어 성능이 중요합니다. GPT-4o, Claude Sonnet 4, Gemini 2.5 시리즈, Grok 4는 한국어 처리 능력이 최상급입니다. 문법, 맥락, 뉘앙스를 정확히 이해하고 자연스러운 한국어 응답을 생성합니다.

저가 모델 중에서는 Mistral Small 3.2, Google Gemma 3 시리즈, Meta Llama 3 시리즈가 한국어를 지원하지만, 프리미엄 모델보다는 성능이 떨어집니다. 간단한 작업에는 충분하지만, 복잡한 문맥 이해나 창의적인 글쓰기에는 한계가 있습니다.

실제 서비스 전에 한국어 테스트를 반드시 수행하세요. 다양한 시나리오와 질문 유형으로 모델을 평가하고, 오류율과 사용자 만족도를 측정합니다. A/B 테스트를 통해 여러 모델을 비교하면 최적의 선택을 할 수 있습니다.

9. 실전 비용 최적화 전략

1) 계층형 모델 아키텍처와 폴백의 결합

모든 작업에 최고급 모델을 쓸 필요는 없습니다. 작업의 중요도와 복잡도에 따라 다른 모델을 사용하는 계층형 구조가 효과적입니다. 예를 들어 초기 분류와 라우팅은 소형 모델로, 핵심 추론은 중급 모델로, 최종 검증은 프리미엄 모델로 처리하면 비용을 크게 줄일 수 있습니다.

각 계층마다 폴백 모델을 설정하세요. 1차 모델이 실패하면 같은 가격대의 다른 모델을 시도하고, 그것도 실패하면 한 단계 상위 모델로 에스컬레이션합니다. 이렇게 하면 서비스 가용성을 유지하면서도 비용을 최소화할 수 있습니다.

# 계층형 폴백 전략 예시

tier_config = { "simple": { "primary": ["google/gemini-2.0-flash-exp:free"], "fallback": ["mistralai/ministral-8b-2512"], "emergency": ["anthropic/claude-haiku-4.5"] }, "complex": { "primary": ["mistralai/mistral-small-3.2-24b-instruct"], "fallback": ["x-ai/grok-3-mini"], "emergency": ["anthropic/claude-sonnet-4"] }, "critical": { "primary": ["anthropic/claude-sonnet-4.5"], "fallback": ["openai/gpt-4o"], "emergency": ["anthropic/claude-opus-4.5"] }

}

2) 프롬프트 엔지니어링으로 비용 절감

같은 작업도 프롬프트를 어떻게 작성하느냐에 따라 필요한 토큰 수가 크게 달라집니다. 명확하고 구체적인 지시문을 작성하면 짧은 응답으로 원하는 결과를 얻을 수 있습니다. 불필요한 설명을 생략하고 핵심만 요청하는 것이 중요합니다.

Few-shot 프롬프트보다 Zero-shot 프롬프트가 토큰을 적게 씁니다. 예제를 여러 개 제공하는 대신 명확한 규칙과 형식을 지정하면 비용을 절감할 수 있습니다. 또한 시스템 프롬프트에 공통 지시사항을 담아두면 매번 반복할 필요가 없습니다.

응답 길이 제한도 효과적입니다. max_tokens 파라미터로 최대 출력 길이를 제한하면 불필요하게 긴 응답을 방지할 수 있습니다. 특히 JSON이나 코드 같은 구조화된 출력에서는 정확한 포맷을 지정하면 토큰을 크게 절약할 수 있습니다.

3) 모니터링과 자동 최적화

실시간 모니터링 시스템을 구축하면 비용과 성능을 동시에 최적화할 수 있습니다. 각 모델의 평균 응답 시간, 성공률, 비용을 추적하고, 일정 기준을 넘으면 자동으로 모델을 전환합니다. 예를 들어 특정 모델의 실패율이 20%를 넘으면 우선순위를 낮추고 다른 모델을 더 많이 사용합니다.

비용 알림을 설정하세요. 일일, 주간, 월간 예산을 정하고 80%에 도달하면 알림을 받습니다. 예산 초과가 예상되면 자동으로 저가 모델로 전환하거나, 특정 기능을 일시적으로 제한하는 로직을 구현할 수 있습니다.

로그 분석을 통해 사용 패턴을 파악하세요. 어떤 작업에 어떤 모델이 가장 효과적인지, 비용 대비 성능이 좋은 모델이 무엇인지 데이터로 확인할 수 있습니다. 이를 바탕으로 폴백 순서를 조정하고 최적화하면 장기적으로 큰 비용 절감 효과를 얻을 수 있습니다.

10. FAQ

Q: 바이브 코딩 초보자에게 추천하는 모델과 폴백 설정은 무엇인가요? A: 처음 시작한다면 무료 모델인 Google Gemini 2.0 Flash Experimental (free)을 1순위로, Kwaipilot KAT-Coder-Pro V1 (free)을 2순위 폴백으로 설정하세요. 두 모델 모두 무료이면서 코딩에 충분한 성능을 제공합니다. 익숙해지면 Claude Sonnet 4나 GPT-4o를 3순위로 추가해 복잡한 작업 시에만 사용하도록 설정하세요. 이렇게 하면 대부분의 작업을 무료로 처리하면서도 중요한 순간에는 프리미엄 품질을 보장할 수 있습니다.

Q: 100만 토큰당 $0.50 미만 모델 중 가장 추천하는 것은? A: Mistral Small 3.2 24B ($0.06 입력, $0.18 출력)와 Grok 4.1 Fast ($0.20 입력, $0.50 출력)를 함께 추천합니다. Mistral은 범용 작업에 가성비가 뛰어나고, Grok은 200만 토큰 컨텍스트로 초대형 문서 처리에 최적입니다. 두 모델을 폴백 쌍으로 설정하면 거의 모든 작업을 저렴한 비용으로 처리할 수 있습니다. Ministral 3 8B ($0.15)를 1순위로, 실패 시 Grok 4.1 Fast를 2순위로 설정하는 것도 좋은 전략입니다.

Q: 무료 모델이 갑자기 작동하지 않을 때 어떻게 대응해야 하나요? A: 폴백 로직을 반드시 구현해야 합니다. 무료 모델은 가용성이 보장되지 않으므로, 최소 2-3개의 대체 모델을 준비하세요. 예를 들어 Gemini 2.0 Flash Experimental (free) → Amazon Nova 2 Lite (free) → Ministral 3 8B (유료) 순으로 시도하는 로직을 만들면 안정성을 크게 향상시킬 수 있습니다. 오류 유형을 분석해 일시적 오류는 재시도하고, 모델 사용 불가 오류는 즉시 폴백하도록 구현하세요.

Q: 한국 서비스에서 중국산 모델을 어떻게 판단하고 사용해야 하나요?

A: 무조건 배제하기보다는 프로젝트 성격과 서버 위치를 확인해 선별적으로 사용하세요. 먼저 해당 모델의 데이터 처리 경로를 확인하고, 중국 본토를 거치지 않는지 체크합니다. 개인 프로젝트나 공개 데이터만 다루는 서비스라면 가성비를 고려해 적극 활용할 수 있습니다. 하지만 금융, 의료 등 민감한 분야나 B2B 서비스라면 고객사의 보안 정책을 먼저 확인하세요. 대중 인식이 좋지 않은 것도 사실이므로, 서비스 약관에 사용 모델을 명시하고 고객에게 투명하게 공개하는 것이 신뢰를 얻는 방법입니다. 폴백 전략에서는 중국산 모델을 하위 순위로 배치해 상황에 따라 유연하게 대응하세요.

Q: 대용량 문서를 분석할 때 Grok과 Gemini 중 어떤 것이 더 좋나요? A: 비용 효율성은 Grok 4.1 Fast가 우수합니다. 200만 토큰 컨텍스트를 $0.20-$0.50에 제공해 초대형 문서를 저렴하게 처리할 수 있습니다. Gemini 2.5 Pro는 100만 토큰에 $1.25-$10로 더 비싸지만 멀티모달 처리와 더 정교한 추론이 가능합니다. 순수 텍스트 분석이라면 Grok을, 이미지나 복잡한 추론이 필요하다면 Gemini를 추천합니다. 두 모델을 폴백 쌍으로 설정해 상황에 따라 자동 전환하는 것이 가장 효율적입니다.

Q: 상용 서비스에서 폴백을 몇 단계까지 설정해야 하나요? A: 최소 3단계를 추천합니다. 1순위는 가격 대비 성능이 좋은 주력 모델, 2순위는 비슷한 가격대의 대체 모델, 3순위는 비싸더라도 안정성이 보장되는 프리미엄 모델로 구성하세요. 예를 들어 Mistral Small 3.2 → Grok 3 Mini → Claude Haiku 4.5 순으로 설정하면 비용을 절감하면서도 99% 이상의 가용성을 보장할 수 있습니다. 중요한 비즈니스 로직에는 4-5단계까지 설정해 완벽한 안정성을 확보하세요.

Q: 모델 전환 시 프롬프트도 수정해야 하나요? A: 기본적으로는 같은 프롬프트를 사용할 수 있지만, 각 모델의 특성에 맞게 최적화하면 더 좋은 결과를 얻습니다. 예를 들어 Claude는 상세한 지시를 선호하고, GPT-4o는 창의적인 작업에 강하며, Grok은 간결한 프롬프트에 잘 반응합니다. 폴백 로직에서 모델별 프롬프트 변형을 준비해두면 각 모델의 강점을 최대한 활용할 수 있습니다. 하지만 초기에는 공통 프롬프트로 시작하고, 사용 데이터를 분석해 점진적으로 최적화하는 것이 효율적입니다.

11. 마무리

AI API 가격을 이해하고 최적의 모델을 선택하는 것은 성공적인 AI 프로젝트의 시작입니다.

핵심 요약:

- 오픈라우터(OpenRouter) 무료 모델 필터로 29개 무료 모델을 즉시 사용할 수 있습니다

- Google Gemini 2.0 Flash Experimental, Kwaipilot KAT-Coder-Pro V1, Meta Llama 3.3 70B가 입문자에게 최적입니다

- 100만 토큰당 $0.50 미만 모델로 연습하고 실전 감각을 익히세요

- Grok 4.1 Fast는 200만 토큰 컨텍스트로 초대형 문서 처리에 탁월합니다

- 폴백 전략은 필수입니다 - 최소 3단계 폴백으로 99% 가용성을 보장하세요

- 한국 서비스에서는 중국산 모델 사용에 신중해야 합니다

- 계층형 아키텍처와 프롬프트 최적화로 비용을 70% 이상 절감할 수 있습니다

이제 오픈라우터 계정을 만들고 무료 모델로 첫 프로젝트를 시작해보세요. 간단한 챗봇이나 텍스트 생성기를 만들어보면서 다양한 모델을 테스트하고, 폴백 로직을 구현하며 실전 경험을 쌓으세요. 바이브 코딩이 당신의 생산성을 10배 이상 높여줄 것입니다.

더 자세한 바이브 코딩 가이드와 모델 최적화 전략은 오픈라우터 공식 문서와 커뮤니티를 참고하세요. AI 개발자 커뮤니티에 참여하면 실전 경험을 공유하고 최신 트렌드를 빠르게 파악할 수 있습니다.